-- Veröffentlicht durch ErSelbst am 11:54 am 26. Sep. 2005

und ich mal hinter mir zu!

:ugly:

-- Veröffentlicht durch Riverna am 11:35 am 26. Sep. 2005

Zitat von skynet um 6:01 am Sep. 26, 2005

mehr brauchst du troll über meinen rechner nicht zu wissen:  (Geändert von skynet um 6:03 am Sep. 26, 2005) |

Genau so wie dein angebliches SLI System wovon du nie Screenshots zu stande gebracht hast... :lol:

Ich bin nun weg und lass die Kinder weiter spielen.

-- Veröffentlicht durch kammerjaeger am 9:19 am 26. Sep. 2005

Zitat von SFVogt um 0:33 am Sep. 26, 2005 Also das SLI nen Flop ist halt ich für ein Gerücht! Erstens gibt es keine andre Möglichkeit die Grafikleistung dermaßen enorm zu steigern als durch 2 Karten. |

Doch, stattdessen eine neuere Karte kaufen.

Ich würde eher eine 6800 nehmen statt zweier 6600 oder eine 7800 statt zweier 6800.

Solange die Leistung einer Karte der neusten Generation alleine reicht, um hohe Qualität in allen Spielen zu nutzen,macht SLI nur für Benchmark-Top10-Jäger Sinn...

Zitat von SFVogt um 0:33 am Sep. 26, 2005 Zweitens ist SLI nie für die Masse gedacht gewesen, sondern nVidia selbst spricht damit die Performancefreaks an! Die wissen sicher selber das dies keinen enormen Umsatz bringt und nur ein kleinerer Teil ist - jedoch vorhanden und ich denke steigend! Auserdem ist dies schon sehr verbreitet wie man in diversen Foren sehen kann. |

Wie bei 3dfx wird es nur eine kurze Phase sein, in der SLI auch für Hardcore-Gamer interessant ist. Erstens reicht die Leistung einer Karte mehr als aus (s.o.), zweitens kaufen sich Hardcore-Gamer ohnehin ständig neue Hardware, und das wird den meisten Usern auf die Dauer zu teuer, wenn sie jedesmal zwei Karten kaufen müssen. Deshalb werden es manche Gamer mal mit SLI versuchen, aber nicht unbedingt ein zweites Mal den gleichen Weg gehen...

Zitat von SFVogt um 0:33 am Sep. 26, 2005 Ihr müßt ja alle Dualcore scheise finden?! Denn bei diesen ist es genau das gleiche Prinzip. Wenn ein Core zu schwach ist, geben wir einen zweiten dazu und steigern so auch die Leistung effektiv - Paralleltität ist mehr im kommen denn je. |

Das eine hat mit dem anderen absolut nix zu tun!

Bei DualCore geht es den meisten Usern um Multitaskingfähigkeiten und nicht primär um Spieleleistung! Wer gleichzeitig Videos umwandelt, brennt, zockt etc. oder z.B. professionelle Musik/Video-Bearbeitung macht, der wird eine DualCore-CPU sehr wohl sinnvoll nutzen, statt sich einen zweiten Rechner hinstellen zu müssen! Bei SLI geht es lediglich darum, mit ein paar Details mehr spielen zu können, was sehr wohl übertrieben und verzichtbar ist, während DualCore bei vielen Usern eindeutig Zeit/Geld-Ersparnis bedeutet! Hinzu kommt noch die Tragweite in Servern, wo Multiprozessor-Systeme schon lange unverzichtbar sind. ;)

Zitat von SFVogt um 0:33 am Sep. 26, 2005 Und letztebns: Blos weil ihr ständig auf den Stromzähler schaut und die Kohle (vielleicht) nicht habt für ein ergibiges SLI System, müßt ihr nicht glei sagen das es nen Flob ist! |

Ich hab die Kohle! Aber neben Aspekten wie zusätzlicher Lautstärke bzw. zusätzlich notwendiger Kühlung sehe ich nicht ein, das Geld zum Fenster rauszuwerfen, nur um noch irgendein Detail höher drehen zu können. Mir reicht die Leistung einer einzelnen Karte mehr als aus, was also will ich mit zwei davon? Nur weil es das gibt und für manche User "nice to have" ist, muß es sich nicht jeder kaufen, der es sich leisten kann.

Traurig finde ich es besonders dann, wenn sich einige vom SLI-Wahn mitreißen lassen, die es sich eigentlich nicht leisten könnten. Aber viele wollen halt immer den "Längsten" unter ihren Freunden haben.

Wer´s braucht... :lol:

Btw.: Bevor jetzt wieder irgendwelche Behauptungen kommen: Ich hab SLI schon im Einsatz erlebt, daher kann ich mir auch eine Meinung darüber erlauben!

-- Veröffentlicht durch N omega G am 8:32 am 26. Sep. 2005

Zitat von skynet um 5:55 am Sep. 26, 2005

1. falsch... 2. falsch... ist ziemlich ausgewogen... 1:1 kann man sagen, die die mich net mögen sind zu 90% eh neider oder intel/ati frösche... :lol: 3. falsch... siehe 2. und ich liebe euren neid, gebt mir mehr davon, macht mich stärker... gebt mir all euren hass!!! :devil: so müssen tombman und ich mit unserem schweren los kämpfen... :blubb: |

neid? lol

auf was sollen wir neidisch? dass du sli hast? LMAO

-- Veröffentlicht durch skynet am 6:01 am 26. Sep. 2005

Zitat von Riverna um 22:58 am Sep. 25, 2005 Und weil dir das so egal ist gammelst du noch mit einer 6800GT und einem Venice 512KB Krüppel rum... :lol: |

mehr brauchst du troll über meinen rechner nicht zu wissen:

(Geändert von skynet um 6:03 am Sep. 26, 2005)

-- Veröffentlicht durch skynet am 5:55 am 26. Sep. 2005

Zitat von N omega G um 14:13 am Sep. 25, 2005 -skynet war unbeliebt -skynet ist unbeliebt -skynet wird unbeliebt bleiben (von der masse) wir sollten aufhören so oft über ihn herzuziehen, das ist die mühe nicht wert... |

1. falsch...

2. falsch... ist ziemlich ausgewogen... 1:1 kann man sagen, die die mich net mögen sind zu 90% eh neider oder intel/ati frösche... :lol:

3. falsch... siehe 2.

und ich liebe euren neid, gebt mir mehr davon, macht mich stärker... gebt mir all euren hass!!! :devil:

so müssen tombman und ich mit unserem schweren los kämpfen... :blubb:

-- Veröffentlicht durch SFVogt am 0:33 am 26. Sep. 2005

Also das SLI nen Flop ist halt ich für ein Gerücht! Erstens gibt es keine andre Möglichkeit die Grafikleistung dermaßen enorm zu steigern als durch 2 Karten. Das dies jedoch nicht die Leistung einer Karte gleich verdoppelt, ist wohl klar und wer darauf immer noch drauf rum reitet der brauch wohl garnicht erst mit reden!

Zweitens ist SLI nie für die Masse gedacht gewesen, sondern nVidia selbst spricht damit die Performancefreaks an! Die wissen sicher selber das dies keinen enormen Umsatz bringt und nur ein kleinerer Teil ist - jedoch vorhanden und ich denke steigend! Auserdem ist dies schon sehr verbreitet wie man in diversen Foren sehen kann.

Drittens: welche Entwicklungskosten? In den ersten Beiträgen verpöhnt ihr nVidia noch das sie ja alles von 3dfx geklaut hätten und bringt jetzt so nen Argument?! Irgendwie passt das nicht ;) Da sie sich sicher das Wissen und die Erfahrung von 3dfx zu Nutze gemacht haben, waren da sicherlich keine enormen Entwicklungskosten.

Ihr müßt ja alle Dualcore scheise finden?! Denn bei diesen ist es genau das gleiche Prinzip. Wenn ein Core zu schwach ist, geben wir einen zweiten dazu und steigern so auch die Leistung effektiv - Paralleltität ist mehr im kommen denn je. Und SLI ist genau das gleiche wie beim Dualcore, nur das man komplexe Grafikkarten nicht ohne weiteres verbinden kann. Ein A64 mit San Diego Core hat hat nur ca 1/3 der Transiistoren einer G70 GPU! Die Parallelisierung ist dabei sicher nicht mit so extremen Entwicklungskosten verbunden wie die Konstrucktion einer doppelt so Leistungstarken Recheneinheit einer einzelnen GPU!

Und letztebns: Blos weil ihr ständig auf den Stromzähler schaut und die Kohle (vielleicht) nicht habt für ein ergibiges SLI System, müßt ihr nicht glei sagen das es nen Flob ist!

(Geändert von SFVogt um 0:42 am Sep. 26, 2005)

-- Veröffentlicht durch Riverna am 22:58 am 25. Sep. 2005

Zitat von skynet um 0:26 am Sep. 25, 2005

für leute wie dich evtl. ja, mir doch schnuppe ob ne karte 500€ oder 1000€ kostet... *pff* |

Und weil dir das so egal ist gammelst du noch mit einer 6800GT und einem Venice 512KB Krüppel rum... :lol:

-- Veröffentlicht durch Notebook am 14:23 am 25. Sep. 2005

Zitat von N omega G um 14:13 am Sep. 25, 2005 -skynet war unbeliebt -skynet ist unbeliebt -skynet wird unbeliebt bleiben (von der masse) wir sollten aufhören so oft über ihn herzuziehen, das ist die mühe nicht wert... |

Auch wieder war. Wobei viele seiner Sprüche wiederum so doof waren, dass man drüber lachen kann.

Ansonsten wohl: Don´t feed the trolls...

-- Veröffentlicht durch N omega G am 14:13 am 25. Sep. 2005

-skynet war unbeliebt

-skynet ist unbeliebt

-skynet wird unbeliebt bleiben

(von der masse)

wir sollten aufhören so oft über ihn herzuziehen, das ist die mühe nicht wert...

-- Veröffentlicht durch Notebook am 13:41 am 25. Sep. 2005

@ErSelbst:

Hey, ich will auch was abhaben von dem Geld!! :lol:

@kammerjäger:

Das ganze Geld geht ja drauf, weil er sich dauernd neue Sackhosen kaufen muß, weil die beim BMXen dauernd zerreißen.:lol:

@DinkPeTe:

Das könnte auch ein Grund für den Geldmangel sein.:thefinger: :yucky:

@Henro

Ganz genau. :thumb:

(Geändert von Notebook um 13:52 am Sep. 25, 2005)

-- Veröffentlicht durch DinkPeTe am 11:33 am 25. Sep. 2005

Zitat von kammerjaeger um 11:09 am Sep. 25, 2005 Komisch nur, daß er dann immer noch keine 7xxx hat, wenn ihm denn die Kohle egal ist... :lol: :blubb: |

Na und? Ihr seit doch nur neidisch weil nur er die Stimmen hört :blubb::lol:

-- Veröffentlicht durch kammerjaeger am 11:09 am 25. Sep. 2005

Komisch nur, daß er dann immer noch keine 7xxx hat, wenn ihm denn die Kohle egal ist... :lol: :blubb:

-- Veröffentlicht durch Henro am 3:02 am 25. Sep. 2005

Zitat von skynet um 0:26 am Sep. 25, 2005

für leute wie dich evtl. ja, mir doch schnuppe ob ne karte 500€ oder 1000€ kostet... *pff* |

oh man ... fanatismuss und begeisterung für eine sache in allen ehren aber man muss dabei nicht so großkotzig sein !

-- Veröffentlicht durch ErSelbst am 1:00 am 25. Sep. 2005

schön - kannst mir gerne die gespaerten 500€ überweisen, wenn se die eh egal sind ....

-- Veröffentlicht durch skynet am 0:26 am 25. Sep. 2005

Zitat von Notebook um 23:54 am Sep. 24, 2005 Sei lieber froh, dass es ATI gibt, sonst wäre Nvidia dank Monopol absolut unerschwinglich! :ohno: |

für leute wie dich evtl. ja, mir doch schnuppe ob ne karte 500€ oder 1000€ kostet... *pff*

-- Veröffentlicht durch Notebook am 23:54 am 24. Sep. 2005

Was Nvidia abzieht, ist einfach nur affig. Wen wollen die damit ansprechen?

Die Eingeweihten wissen doch, dass die 7800 GTX eh besser als die X850 ist...sind ja auch andere Kartengenerationen.

@skynet:

Warum habe ich beim Lesen deiner Beiträge immer nur das Verlangen, dich als Ständer für dein eigenes BMX-Fahrrad zu verwenden? :grr:

Jeder Schimpanse würde intelligentere Beiträge schreiben. :mama: :bonk:

Sei lieber froh, dass es ATI gibt, sonst wäre Nvidia dank Monopol absolut unerschwinglich! :ohno:

-- Veröffentlicht durch kammerjaeger am 22:36 am 24. Sep. 2005

Aber die Verkaufszahlen decken nicht die Entwicklungskosten. ;)

SLI (und Crossfire) sind Marketing-Objekte, die für sich alleine gesehen nicht wirtschaftlich wären und in erster Linie dem Ansehen des Herstellers dienen.

Ist ähnlich wie damals der BMW Z1, der in Relation zur verkauften Stückzahl Entwicklungs- und Produktionskosten von afaik über 100.000,- DM hatte, aber für rund 90.000,- DM verkauft wurde. Trotzdem war der Wagen positiv für das damalige Firmenimage...

-- Veröffentlicht durch skynet am 18:13 am 24. Sep. 2005

Zitat von kammerjaeger um 16:56 am Sep. 24, 2005 Wer´s braucht... :blubb: SLI hat sich als ziemlicher Flop erwiesen und wird es auch weiter bleiben (genauso wie Crossfire markttechnisch kaum Relevanz haben wird). Solange es nicht preislich eine echte Alternative für den Massenmarkt bietet, wird sich der Erfolg in Grenzen halten und nicht viel mehr als eine "Technik-Schau" sein. ;) |

sli hat sich sicher nicht als flop erwiesen, weil die leute dies ansprechen sollte, die habens auch. :kidding:

-- Veröffentlicht durch kammerjaeger am 16:56 am 24. Sep. 2005

Wer´s braucht... :blubb:

SLI hat sich als ziemlicher Flop erwiesen und wird es auch weiter bleiben (genauso wie Crossfire markttechnisch kaum Relevanz haben wird). Solange es nicht preislich eine echte Alternative für den Massenmarkt bietet, wird sich der Erfolg in Grenzen halten und nicht viel mehr als eine "Technik-Schau" sein. ;)

-- Veröffentlicht durch Roughneck Rico am 16:39 am 24. Sep. 2005

Papiertiger -- > ATI Crossfire

Realität -- > nVidia SLI Multi GPU

http://www.nordichardware.com/news,1909.html

-- Veröffentlicht durch BUG am 2:37 am 23. Sep. 2005

..naja SSAA is schon nich schlecht, wenn es nur nich so viel Leistung fressen würde. :blubb: ..TSAA geht da schon einen inteligenteren Weg (kann meine Karte aber nicht). :( ..abundzu können die Alpha Texturen ganz schön nervig sein. ;)

cu

BUG

-- Veröffentlicht durch SFVogt am 2:22 am 23. Sep. 2005

...es wird wohl eher so sein wie du sagst :thumb: :lol:

-- Veröffentlicht durch kammerjaeger am 1:33 am 23. Sep. 2005

Naja, es soll auch Leute geben, die Flöhe husten hören können. Möglicherweise kann er ja Dinge sehen, die unsere mißgebildeten Augen nicht erkennen... :lol:

-- Veröffentlicht durch SFVogt am 18:17 am 22. Sep. 2005

Jo, dann lass mich mal teilhaben :thumb: zeig mal nen Pic mit nem Vergleich oder so der beiden Einstellungen ;)

-- Veröffentlicht durch skynet am 16:52 am 22. Sep. 2005

Zitat von SFVogt um 14:02 am Sep. 22, 2005 Okay, hier ist wohl so ein Genie der noch Unterschiede sieht :thumb: Ich sags mal so, mit 4xAA und 8xAF hat das eine Qualität, welche sich noch leicht erkennbar von 2xAA/4xAF ist bzw man die Unterschiede recht deutlich sieht. Ab 4xAA/8xAF sind die Unterschiede so gut wie garnicht zu erkenn und dann nur, wenn man irgendwelche Sceens vergößert. Und wie ich schon sagte kann man keine Standbilder spielen. Bei SingleKarten würde ich deswegen eigentlich nicht höher gehen - ich rede von 1280x1024er Auflösung in der ich Game. Bei SLI ist es ja "zwingend" gleich min 8xAA/16xAF einzustellen, denn sonst hat SLI kein Sinn und ist nur Geldverschwendung. |

lol, ich sehe den unterschied zwischen 4xAA und 8xSSAA sehr wohl, schon aus dem grund das die texturen mitgeglättet werden, das gesammte bild sieht besser und klarer aus.

-- Veröffentlicht durch SFVogt am 14:02 am 22. Sep. 2005

Zitat von skynet um 10:40 am Sep. 22, 2005

wohl noch nie 8xSSAA und TSAA gesehn wa? :noidea: |

Okay, hier ist wohl so ein Genie der noch Unterschiede sieht :thumb: Ich sags mal so, mit 4xAA und 8xAF hat das eine Qualität, welche sich noch leicht erkennbar von 2xAA/4xAF ist bzw man die Unterschiede recht deutlich sieht. Ab 4xAA/8xAF sind die Unterschiede so gut wie garnicht zu erkenn und dann nur, wenn man irgendwelche Sceens vergößert. Und wie ich schon sagte kann man keine Standbilder spielen. Bei SingleKarten würde ich deswegen eigentlich nicht höher gehen - ich rede von 1280x1024er Auflösung in der ich Game. Bei SLI ist es ja "zwingend" gleich min 8xAA/16xAF einzustellen, denn sonst hat SLI kein Sinn und ist nur Geldverschwendung.

-- Veröffentlicht durch Henro am 13:58 am 22. Sep. 2005

na wow ... anderthalb seiten um festzustellen das es keinen 2200+ Palo gab. Ich bin begeistert ;)

-- Veröffentlicht durch kammerjaeger am 13:26 am 22. Sep. 2005

Zitat von skynet um 10:42 am Sep. 22, 2005 es gab nie einen palomino 2200+ :kidding: |

Stimmt, der 2100+ war der größte Palo...

-- Veröffentlicht durch N omega G am 12:45 am 22. Sep. 2005

Zitat von Ino um 12:40 am Sep. 22, 2005 sky du bist mein gott :godlike: einfach der hammer :lol: nicht irronisch gemeint |

:megaeek:

:noidea:

-- Veröffentlicht durch Ino am 12:40 am 22. Sep. 2005

sky du bist mein gott :godlike:

einfach der hammer :lol:

nicht irronisch gemeint

;)

(Geändert von Ino um 13:14 am Sep. 22, 2005)

-- Veröffentlicht durch skynet am 10:42 am 22. Sep. 2005

Zitat von kammerjaeger um 9:00 am Sep. 22, 2005 Du willst von einer uralten Karte auf aktuelle Technik schließen??? :blubb: Was bitteschön hat das mit den aktuellen Karten zu tun? Ist ein A64 etwa ein Heizkraftwerk, nur weil der Athlon 1400 oder Palomino 2200+ sauheiß wurden? Nvidia kann froh sein, daß sie damals durch STMicro überhaupt ins 3D-Karten-Geschäft reingekommen sind, sonst wären sie heute evtl. gar nicht mehr da... ;) |

es gab nie einen palomino 2200+ :kidding:

-- Veröffentlicht durch skynet am 10:40 am 22. Sep. 2005

Zitat von SFVogt um 0:57 am Sep. 22, 2005 Und alles über 4xAA sieht man sowieso keinen Unterschied mehr beim Gamen - zumindest ist das bei mir der Fall. |

wohl noch nie 8xSSAA und TSAA gesehn wa? :noidea:

-- Veröffentlicht durch skynet am 10:39 am 22. Sep. 2005

Zitat von Beomaster um 0:41 am Sep. 22, 2005 die GF4 hat gute Bilder gemacht? also wenn dran denke wie geil die Games auf einmal mit ner 5900XT ausgesehn ham weiß ich ja nich :blubb: |

wenn ich drann denke... also die BQ auf der GF4 war genausogut, das AF sogar noch nen stück besser...

und komme mir net mit irgend ner sülze, ich hatte mehrere karten beider baureihen!

-- Veröffentlicht durch Henro am 10:39 am 22. Sep. 2005

is nicht der HQ modus der einzige der nicht flimmert bei NV ? ;)

-- Veröffentlicht durch skynet am 10:37 am 22. Sep. 2005

Zitat von SFVogt um 0:39 am Sep. 22, 2005 Es soll ja solche Genies geben, die während eines schnellen 3D Shooters immernoch die Unterschiede des "super hyper extrem" guten ATIs 4xAA/8xAF und NVs "grotten schlechtem" 4xAA/8xAF sehen :crazy: |

das AA ist gleichwertig, das AA des G70 ist sogar besser als alles an AA was ATI jemals zu bieten hatte, besonders dankt TSAA!

das AF ist seit jeh her auf NV karten besser, inzwischen nur noch marginal und nurnoch im HQ modus, aber immerhin.

-- Veröffentlicht durch skynet am 10:35 am 22. Sep. 2005

Zitat von kammerjaeger um 0:48 am Sep. 22, 2005 Nicht nur das. Ich fand z.B. auch die Farben bei der 8500 einfach besser als bei der GF4TI. Keine Frage: Die GF4TI war eine gute Karte (hab ja selbst einige gehabt), aber im Nachhinein hat sich sowohl bei der 8500/9500 ggü. der GF4TI als auch bei der 9xxx ggü. der FX herausgestellt, daß die ATI-Karten besonders bei neueren Spielen am längeren Hebel sitzen. Wie ein guter Wein, der mit der Zeit immer besser wird... ;) |

*krrrmmppfffff*

ich falle hier gleich vor lachen vom bett!

-- Veröffentlicht durch kammerjaeger am 9:00 am 22. Sep. 2005

Du willst von einer uralten Karte auf aktuelle Technik schließen??? :blubb:

Was bitteschön hat das mit den aktuellen Karten zu tun?

Ist ein A64 etwa ein Heizkraftwerk, nur weil der Athlon 1400 oder Palomino 2200+ sauheiß wurden?

Nvidia kann froh sein, daß sie damals durch STMicro überhaupt ins 3D-Karten-Geschäft reingekommen sind, sonst wären sie heute evtl. gar nicht mehr da... ;)

-- Veröffentlicht durch Roughneck Rico am 7:31 am 22. Sep. 2005

Zitat von BDKMPSS um 15:41 am Sep. 20, 2005 2. Ati hat das nicht einfach so aufs blatt geschmiert, es gab schon Dual GPU karten von ati |

Ja klar die ach so tolle Rage Fury Maxx :gripe:

Ich war so ein Trottel und hatte die damals gekauft.

Das Teil war der letzte sch****, mall hatteste ca. 4 cm breite Streifen über den ganzen Monitor, mal blieb das Bild für 2 - 3 Sec. stehen, mal war der halbe Bildschirm schwarz usw. usw.

Wer die Karte damals hatte weiß wie "fortschritlich" ATI wirklich ist.

-- Veröffentlicht durch AssassinWarlord am 7:21 am 22. Sep. 2005

klar hatt 3dfx nur darum ein SLI gespann gebaut um hinterher zu kommen mit der performance, das haben die aber auch nur als übergangslösung gebaut bis die Voodoo Rampage rauskamm, den die war eine reine Singel GPU graka und auch mit DDR Ram, so wie die Voodoo Daytona ;) (also die Voodoo4 4200). Und die konnte es mit ner GF3 aufnehmen. leider war 3dfx da schon so gut wie platt...des war am 15.12.2000 :waterfall: aber es existieren 2 lauffähige Rampage karten, die aber nun in den händen von samlern liergen :thumb::godlike:

-- Veröffentlicht durch kammerjaeger am 1:58 am 22. Sep. 2005

Stimmt. Naja, was will man nach ein paar Bier noch erwarten...

Deshalb leg ich mich jetzt besser schlafen. :nabend:

-- Veröffentlicht durch BUG am 1:48 am 22. Sep. 2005

Zitat von kammerjaeger um 1:14 am Sep. 22, 2005 Im Prinzip bin ich auch Deiner Meinung. Hier ging es jedoch um Features (OpenGL 1.4) und Performance (u.a. 24bit vs. verschenkte 32bit). Und da ist der Sieger klar. ;) |

cu

BUG

-- Veröffentlicht durch SFVogt am 1:24 am 22. Sep. 2005

Eigentlich gehts hier um die nVdia Presentation :blubb:

...und mit den Features hast du angefangen, ich meinte die ganze Zeit schon nur die Bildqualität :lol:

-- Veröffentlicht durch kammerjaeger am 1:14 am 22. Sep. 2005

Zitat von SFVogt um 0:57 am Sep. 22, 2005 Pfui, ich hasse Wein! :lol: Mal ehrlich, dieses ganze Bildqualitätsgeseusel ist doch für die Katz! Ich finde beide Hersteller nehmen sich im Game nichts. Schließlich spiele ich in "bewegten Bildern" und nicht irgendwelche Screenshots! Denn nur auf diesen sind die minimalen Miniunterschiede zu erkennen. Und alles über 4xAA sieht man sowieso keinen Unterschied mehr beim Gamen - zumindest ist das bei mir der Fall. |

Im Prinzip bin ich auch Deiner Meinung.

Hier ging es jedoch um Features (PS 1.4) und Performance (u.a. 24bit vs. verschenkte 32bit). Und da ist der Sieger klar. ;)

(Geändert von kammerjaeger um 8:54 am Sep. 22, 2005)

-- Veröffentlicht durch SFVogt am 0:57 am 22. Sep. 2005

Pfui, ich hasse Wein! :lol:

Mal ehrlich, dieses ganze Bildqualitätsgeseusel ist doch für die Katz! Ich finde beide Hersteller nehmen sich im Game nichts. Schließlich spiele ich in "bewegten Bildern" und nicht irgendwelche Screenshots! Denn nur auf diesen sind die minimalen Miniunterschiede zu erkennen. Und alles über 4xAA sieht man sowieso keinen Unterschied mehr beim Gamen - zumindest ist das bei mir der Fall.

(Geändert von SFVogt um 0:59 am Sep. 22, 2005)

-- Veröffentlicht durch Beomaster am 0:57 am 22. Sep. 2005

na, dann sind ja due Voodoo 5 besonders edle Tropfen :godlike:

-- Veröffentlicht durch kammerjaeger am 0:48 am 22. Sep. 2005

Zitat von Beomaster um 0:41 am Sep. 22, 2005 die GF4 hat gute Bilder gemacht? also wenn dran denke wie geil die Games auf einmal mit ner 5900XT ausgesehn ham weiß ich ja nich :blubb: |

Nicht nur das. Ich fand z.B. auch die Farben bei der 8500 einfach besser als bei der GF4TI.

Keine Frage: Die GF4TI war eine gute Karte (hab ja selbst einige gehabt), aber im Nachhinein hat sich sowohl bei der 8500/9500 ggü. der GF4TI als auch bei der 9xxx ggü. der FX herausgestellt, daß die ATI-Karten besonders bei neueren Spielen am längeren Hebel sitzen.

Wie ein guter Wein, der mit der Zeit immer besser wird... ;)

-- Veröffentlicht durch Beomaster am 0:41 am 22. Sep. 2005

die GF4 hat gute Bilder gemacht?

also wenn dran denke wie geil die Games auf einmal mit ner 5900XT ausgesehn ham weiß ich ja nich :blubb:

-- Veröffentlicht durch SFVogt am 0:39 am 22. Sep. 2005

Naja, mal ehrlich, muß man die GeF4 in BF2 zum Vergleich ziehen?! Eine so betagte Karte und so ein aktuelles Game, find ich net gerade ein gutes Beispiel. Es wurde auch nur gesagt, das die Karte von der Bildqualität (AF & AA) das beste bis dato gewesen ist, nicht von der Spielbarkeit in diesen Features!

Ich hab mit diesem ganzen gequatsche sowieso nichts am Hut. Es soll ja solche Genies geben, die während eines schnellen 3D Shooters immernoch die Unterschiede des "super hyper extrem" guten ATIs 4xAA/8xAF und NVs "grotten schlechtem" 4xAA/8xAF sehen :crazy:

(Geändert von SFVogt um 0:40 am Sep. 22, 2005)

-- Veröffentlicht durch kammerjaeger am 0:37 am 22. Sep. 2005

Zitat von ErSelbst um 0:32 am Sep. 22, 2005

Bei mir lief es auf ner GF4 Ti4200 ohne Probs :noidea: |

Sorry, meinte natürlich BF2... ;)

Wird geändert.

-- Veröffentlicht durch ErSelbst am 0:32 am 22. Sep. 2005

Zitat von kammerjaeger um 23:45 am Sep. 21, 2005 (siehe z.B. HL2, was auf einer 8500 läuft, auf der GF4TI aber nicht). |

Bei mir lief es auf ner GF4 Ti4200 ohne Probs :noidea:

-- Veröffentlicht durch kammerjaeger am 0:27 am 22. Sep. 2005

Zitat von SFVogt um 0:08 am Sep. 22, 2005 Hmmm, komisch :noidea: sonst les ich immer auf andren Seiten, das der 8500 in Sachen Grafikqualität der reinfall war und die GeF4 bis dato die Beste Bildqualität geliefert hat?! |

Das müssen eingefleischte NV-Fanboys gewesen sein... ;)

Die 8500 hat PS1.4, die GF4TI nicht. Daher läuft sie nur emuliert mit BF2, was absolut grottig aussieht. ;)

Die GF4TI war zwar in den meisten Engines schneller als die 8500, was sich erst mit der 9500 änderte, aber in der Technik war ATI damals überlegen. Man hat sich eben schon damals bei ATI mehr an die Vorgaben der Industrie gehalten, um DirectX- und OpenGL-Standards so weit als möglich auszunutzen, während Nvidia teilweise am Markt vorbei produziert (siehe 32bit bei der FX, obwohl DX9 nur 24bit nutzt/fordert, wodurch die FX entweder schlechter aussah, da sie auf 16bit runter mußte, oder teilweise unspielbar langsam wurde), was man dann durch Logo-Sponsoring in Spielen wieder versucht wettzumachen...

Auch mit der 6xxx hat man wieder versucht, durch Pseudo-HDR und SM3.0 einen technologischen Vorteil zu erreichen, obwohl es kein echtes HDR ist und SM3.0 nur von einer Hand voll Spielen unterstützt wird (was NV teilweise viel Geld gekostet hat, um überhaupt genutzt zu werden...).

NV sollte meiner Meinung nach mal wieder stärker an den Vorgaben des Marktes arbeiten, dann braucht man nicht so viel Geld in Pseudo-Features investieren, die keiner braucht und/oder nutzt. Sonst werden sie in Zukunft weiter Marktanteile verlieren, besonders im Notebook-Segment, wo der Radeon Mobility immer stärker wird.

(Geändert von kammerjaeger um 8:55 am Sep. 22, 2005)

-- Veröffentlicht durch SFVogt am 0:08 am 22. Sep. 2005

Hmmm, komisch :noidea: sonst les ich immer auf andren Seiten, das der 8500 in Sachen Grafikqualität der reinfall war und die GeF4 bis dato die Beste Bildqualität geliefert hat?!

nV hat ist nicht mit ihrer 7er Reihe zu früh dran, sondern ATI hingt schon Monate hinterher! Ich glaube mal in den News stand, das beide Hersteller den Zyklus einer Generation auf 9-12 Monate erhöhen wollten. Vor der 6er waren es ja eher immer so 6 Monate. Hoffentlich bleibt es jetzt auch dabei, und ATI zeigt endlich in knapp zwei Wochen was Sache ist!

-- Veröffentlicht durch kammerjaeger am 23:45 am 21. Sep. 2005

Nvidia hat halt zu der Zeit ein mörderisches Tempo vorgelegt und jedes halbe Jahr einen Nachfolger gebracht. Da konnte 3dfx nicht ganz mithalten und hat den Kürzeren gezogen, denn die OEM´s (wie Medion & Co.) brauchten verläßliche Zyklen, um z.B. den Weihnachts-PC zu planen.

Inzwischen ist das Tempo nicht mehr so hoch und ATI hält mehr als nur Schritt. Mal hat der eine, mal der andere Hersteller die Nase vorn.

Nach der grottigen FX-Reihe hat Nvidia mit der 6xxx den Schritt in die richtige Richtung gemacht und konnte in der Performance zu ATI aufschließen, die seit der 9500 (ggü. der TI4xxx bis hin zur FX59xx) immer klar die Nase vorn hatten und selbst mit der 8500 schon die für Spiele relevanten besseren Features hatten (siehe z.B. BF2, was auf einer 8500 läuft, auf der GF4TI aber nicht).

Mit der 7xxx war NV halt diesmal etwas früher dran als das Gegenstück von ATI, deshalb haben sie kurzfristig die Führung übernommen. Wann und wie ATI zurückschlagen wird, werden wir sehen...

(Geändert von kammerjaeger um 0:38 am Sep. 22, 2005)

-- Veröffentlicht durch SFVogt am 23:22 am 21. Sep. 2005

Wie "zulange" gebraucht? Wozu ne Dual Graka bauen wenn es überhaupt nix bringt? Oder willst du mir erzählen das ATIs Dual Karte für AGP der Überflierger war? nV hat genau dann Dual GPU Systeme gebracht, wenn die Vorrausetzung gegeben waren für ein ordentliches Dual Gespann - was mit PCIe kam!

Das 3dfx so an ihrem Multi GPU System fest hielt, lag bestimmt nicht daran, das Multi GPU so hammer geil ist, sondern weil ein einzelner Chip rein garnichts gegen ein nV Chip ausrichten konnte!

(Geändert von SFVogt um 23:24 am Sep. 21, 2005)

-- Veröffentlicht durch AssassinWarlord am 23:06 am 21. Sep. 2005

nvidia hatt aber zu lange gebraucht, um erstmal ne Dual GPU Graka zu bauen..da war ATI schneller (von den großkonzernen jedenfals)

-- Veröffentlicht durch SFVogt am 22:50 am 21. Sep. 2005

lol

Wenn 3dfx nicht fähig war ein Unternehmen zu führen, ist der ganz normale Lauf der Dinge, das sie von andren geschlugt wird oder Konkurs anmelden etc! Aber da es nun gerade nVidia war können sich ja jetzt einige dran aufgeilen :crazy:

Mansche können sich wohl nicht damit abfinden, das nV derzeit am längeren Hebel sitzt! Auserdem hätte ATI genauso schnell Crossfire bringen können, das nötige Dual GPU Wissen hatten sie! Es wurde schon gesagt, bevor es erste PCIe Boards gab, das Dualgrafiklösung wieder machbar wären durch die Technik! Aber jetzt zu sagen, das nV ja auf 3dfx Technik zurückgreifen konnte, ist nur ne billige Ausrede dafür, das man nicht einsehen will das ATI gepennt hat gleich auf den Zug aufzuspringen!

(Geändert von SFVogt um 22:55 am Sep. 21, 2005)

-- Veröffentlicht durch AssassinWarlord am 20:21 am 21. Sep. 2005

übernommen? nVidia hatt sich die hände gerieben und genüsslich 3dfx den letzten schuss verpasst, und zur gnade einfach mal so lausige 112Mio US Dollar rübergeschoben und da 3dfx

eh schon geschwächt war, konnten die nicht mehr wiederstehen :biglol:

aber hatt nVidia eigentlich vor dem kauf von 3dfx was mit dual gebaut? oder war da ATI, 3dfx, 3dlabs und matrox die einzigsten, die was geschraubt haben?

-- Veröffentlicht durch SFVogt am 19:58 am 21. Sep. 2005

Das wage ich aber stark zu bezweifeln das ATI mit ihrem Crossfire das Rad komplett neu erfindet ;)

Nix mit komplett neuer Technologie. Schließlich haben die ja auch schon Erfahrung mit Dual GPU Karten ;)

Also wo ist da der Vorteil von nVidia?! Und geklaut haben die schon gleich garnichts von 3dfx. Wie jeder weiß wurde 3dfx von nV mit allem drum un dran übernommen :thumb:

(Geändert von SFVogt um 20:05 am Sep. 21, 2005)

-- Veröffentlicht durch N omega G am 8:36 am 21. Sep. 2005

Zitat von QnkeI um 15:24 am Sep. 20, 2005

GEKAUFT!! nVidia hat es von 3dfx gekauft! |

was glaubst du warum ich das in anführungszeichen geschrieben hab..

Zitat von Henro um 15:52 am Sep. 20, 2005 Ihr redet Crossfire so schön, dabei ist es noch garnet draussen. Bin mal gespannt wie kompatibel das wird. Und du redest es schlecht obwohls nicht draussen ist ... bist genauso blöd ! |

:lolaway:

(Geändert von N omega G um 8:37 am Sep. 21, 2005)

-- Veröffentlicht durch SFVogt am 0:08 am 21. Sep. 2005

lol

...wer glaubt, das diese Presentation purer Ernst ist, der glaubt auch das der R520XT doppelt so schnell, nur halb so warm und halb soviel Strom verbraucht wie die GTX :blubb:

nVidia wollte sicher ein bischen sticheln und lustig ist es doch alle mal :lol:

Und ja, R520 Crossfire wird sicherlich mehr hinten rausholen! ATI kann mit Crossfire die Leistung aufs 2,5x einer einzelnen Karte erhöhen. ATI kann nämlich zaubern :blubb:

nV sollte wirklich schon 6800Ultra SLI mit X850XT Crossfire vergleichen. Und das da Crossfir gewinnt im Leistungsvergleich ist klar! Und zwar nicht weil Crossfire der ultra Hipe ist, sondern weil eine X850XT schon schneller ist als eine 6800Ultra. Wäre wohl ziemlich peinlich für ATI wenn sich das unter Crossfire ändern würde ;)

Und hier noch was zum Thema "Crossfire ist viel flexibler als SLI" :lol:

MUSSTE MA PUSHEN HIER DROOF

(Geändert von SFVogt um 0:26 am Sep. 21, 2005)

-- Veröffentlicht durch svenska am 23:07 am 20. Sep. 2005

naja nvidia "truth" sind aber nicht wirklich so tolle argumente. das is ne billige präsentation. aber lustig ist das trotzdem.

klar is aber auch, dass nvidia ati plattzumachen, bei einigen sachen mögen sie wohl besser sein, aber dennoch abwarten was am ende rauskommt und dann vergleichen (& hetzen *g* )

-- Veröffentlicht durch skynet am 22:38 am 20. Sep. 2005

Zitat von AssassinWarlord um 21:20 am Sep. 20, 2005 @Fualpeltz, wers braucht? naja...Skynet (errrinnert mich gerad irgendwie an Skynetix was auch immer das ist :noidea: ) braucht des :biglol: der sabbert doch schon wie so nen hund der in ner sauna ist und vor dem ein riesiger fleischbesetzter knochen liegt :lolaway: |

*psst* ;)

-- Veröffentlicht durch AssassinWarlord am 21:20 am 20. Sep. 2005

Naja also bilder ausgedruckt habe ich nur von der Realizm800, von der Mercury, der AAlchemy, Voodoo5 6000, tjoar, sonst habe ich keine weiteren von Grakas...nur von ner Western Digital Raptor, ne Atlas, und ne billiche barracuda :blubb:

@Fualpeltz, wers braucht? naja...Skynet (errrinnert mich gerad irgendwie an Skynetix was auch immer das ist :noidea: ) braucht des :biglol: der sabbert doch schon wie so nen hund der in ner sauna ist und vor dem ein riesiger fleischbesetzter knochen liegt :lolaway:

(Geändert von AssassinWarlord um 21:32 am Sep. 20, 2005)

-- Veröffentlicht durch faulpelz am 21:17 am 20. Sep. 2005

sowas kommt von dir sky?? ich hätte jezz mit "das habe ich bald sowieso" gerechnet.:blubb:

ne aber hast schon recht wer braucht das??

-- Veröffentlicht durch skynet am 20:56 am 20. Sep. 2005

Zitat von AssassinWarlord um 18:31 am Sep. 20, 2005 naja mir ist des eh alle gleich, einer der beiden sollte lieber erstmal an die leistung von der 3dfx SLI technik rann kommen, da konnte das SLI 32 GPUs verknüpfen, ohne das dabei ein spiel dafür geschrieben werden muste :buck: |

selbst NV45 kann schon min. bis zu 64GPUs im SLI unterbringen... :godlike:

G70 sowieso...

aber nun bitte das board und das netzteil das dieses schaffen soll, starkstromleitung, 16x NF4 Pro chipsatz mit jeweils 32 lanes für die grakas sprich 8 lanes pro karte.... und dann 32 PCIe steckplätze. :buck:

-- Veröffentlicht durch Henro am 20:27 am 20. Sep. 2005

man das muss er auch jedes mal bringen wenns um sowas geht :lol:

Druckst du dir die Bilder auch aus umse anne wand zu hängen ? ;)

-- Veröffentlicht durch DexterDX1 am 20:10 am 20. Sep. 2005

Yeah, Assassin!

:kick: it!

-- Veröffentlicht durch AssassinWarlord am 18:31 am 20. Sep. 2005

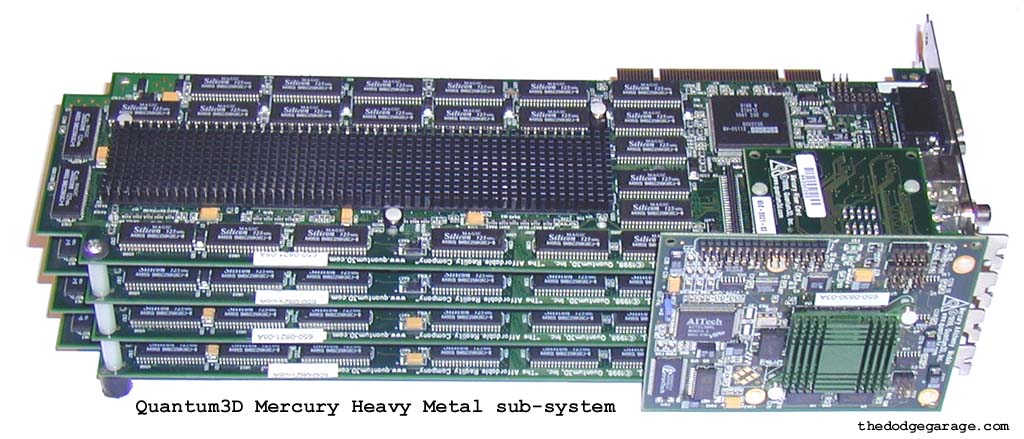

naja mir ist des eh alle gleich, einer der beiden sollte lieber erstmal an die leistung von der 3dfx SLI technik rann kommen, da konnte das SLI 32 GPUs verknüpfen, ohne das dabei ein spiel dafür geschrieben werden muste :buck:

So muss das sein:

32x Voodoo2 Chipsatz im SLI verbund :godlike:

da sind 16 GPUs:

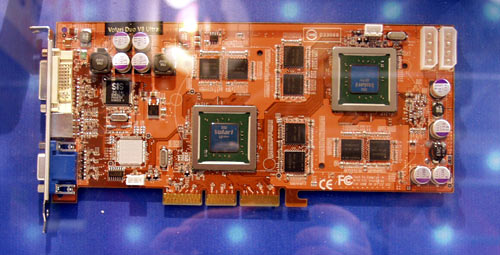

und hier 8x VSA100, also sozusagen zwei Voodoo5-6000 Grakas im SLI ;)

ach ja, ATI hatt schon lange vor nVidia eine art SLI gebaut, da hatt sogar 3dfx noch gelebt, also nVidia hatte noch keine technik zum kopieren (was die letzendlich nichmal hinbekommen haben :lolaway: )

und die kennt mitlerweile auch fast jeder:

und Matrox hatt da auch nicht geschlafen mit ihrer "4xG200GPU auf einem PCB Kärtchen"

Ja sogar 3dLabs hatt da was im angebot :D

512bit 640MB DDR3 speicheranbindung, 64GB/s Speicherdurchsatz, Duale 3840 x 2400 auflösung möglich,...

und das Volary auch was hatt, weis ja auch jeder

(Geändert von AssassinWarlord um 21:14 am Sep. 20, 2005)

-- Veröffentlicht durch skynet am 17:30 am 20. Sep. 2005

Zitat von Henro um 15:52 am Sep. 20, 2005 Son schwachsinn ! Eine Karte muss Crossfire fähig sein um als Master karte zu funktionieren ... und das weils auch PCIe Grakas gibt die schon da waren bevor es crossfire gab! Also für die abwärtskompatibilität zu älteren PCIe Karten. |

er meint das die CF(master) karte selber nicht alleine laufen kann, und da hat er recht, sie funktioniert nur mit der slave-karte zusammen. :)

-- Veröffentlicht durch DexterDX1 am 16:46 am 20. Sep. 2005

Zitat von QnkeI um 16:43 am Sep. 20, 2005 @DexterDX1 Das habe ich so von WinFuture übernommen. Hab vergessen die Quelle zu nennen, habs nachgeholt! |

Dann nehme ich natürlich den :godlike: zurück.

-- Veröffentlicht durch QnkeI am 16:43 am 20. Sep. 2005

Zitat von Henro um 15:52 am Sep. 20, 2005

Und du redest es schlecht obwohls nicht draussen ist ... bist genauso blöd !

Son schwachsinn ! Eine Karte muss Crossfire fähig sein um als Master karte zu funktionieren ... und das weils auch PCIe Grakas gibt die schon da waren bevor es crossfire gab! Also für die abwärtskompatibilität zu älteren PCIe Karten.

Was ist denn damit ? Du hast auch keine Argumente sondern fragst einfach was damit ist :blubb: Wie immer estmal hirn einschalten und dann posten ... aber du scheintst in letzter zeit eh n pupertären dummheitsschub zu haben oder du lässt Alex deinen account mitbenutzen. Naja scheint ja in der Familie zu liegen ;) |

Ich habe geschrieben, dass man eine Crossfire-Karte kaufen muss. Hab net gesagt, das beide Crossfire sein müssen.

Zum ATI-Chipsatz: Das meinte ich zu nVidia Argumenten in der Präsentation.

Wäre schön, wenn du meine Familie da rauslassen würdest! Ich urteile auch nicht über deine.

@BDKMPSS Und damals ist die 2-Chip-Lösung auch gefloppt, weil sie keine Leistung hatte ;)

@DexterDX1 Das habe ich so von WinFuture übernommen. Hab vergessen die Quelle zu nennen, habs nachgeholt!

-- Veröffentlicht durch Ino am 16:37 am 20. Sep. 2005

:lolaway:

also im endeffekt bringt die beidesn sachen NOCH nichts besser gesagt für den preis bringt das nichts! also eine graka reicht aus!

vielleicht in 1-2 jahren wenn das ganze etwas ausgereift ist werden wir weiter sehen aber jetzt finde ich das ganze nur Quark!

-- Veröffentlicht durch DexterDX1 am 16:00 am 20. Sep. 2005

Ein :godlike: auf die Hellseherei des Threaderöffners!

-- Veröffentlicht durch Henro am 15:52 am 20. Sep. 2005

Ihr redet Crossfire so schön, dabei ist es noch garnet draussen. Bin mal gespannt wie kompatibel das wird. |

Und du redest es schlecht obwohls nicht draussen ist ... bist genauso blöd !

Crossfire hat schon den fetten Nachteil, das man eine spezielle "Crossfire"-Karte kaufen muss. Bei nVidia kann ich die beiden Karten jederzeit wieder getrennt verwenden. Crossfire-Karten laufen nicht alleine. |

Son schwachsinn ! Eine Karte muss Crossfire fähig sein um als Master karte zu funktionieren ... und das weils auch PCIe Grakas gibt die schon da waren bevor es crossfire gab! Also für die abwärtskompatibilität zu älteren PCIe Karten.

Und was ist mit ATIs Chipsatz?? Da habt ihr wohl keine Gegenargumente. |

Was ist denn damit ? Du hast auch keine Argumente sondern fragst einfach was damit ist :blubb:

Wie immer estmal hirn einschalten und dann posten ... aber du scheintst in letzter zeit eh n pupertären dummheitsschub zu haben oder du lässt Alex deinen account mitbenutzen. Naja scheint ja in der Familie zu liegen ;)

-- Veröffentlicht durch BDKMPSS am 15:41 am 20. Sep. 2005

und ? 1. hat Linux auch alles was M$ in 2 Jahren als beta bringt und

2. Ati hat das nicht einfach so aufs blatt geschmiert, es gab schon Dual GPU karten von ati, da hat sich NV noch auf den wir-sind-die-besten-und-werden-es-immer-bleiben-Lorberen ausgeruht

3. ich warte lieber 2 Jahre, als mir irgend so ein sinnlosen schrott von NV zu kaufen (moment, ich will auch Crossfire nicht haben...)

Naja EGAL

-- Veröffentlicht durch QnkeI am 15:24 am 20. Sep. 2005

Zitat von N omega G um 11:07 am Sep. 20, 2005 1. dass crossfire paar probleme am anfang hat, ist ja wohl klar, das ist eine NEUE technologie und die muss erst entwickelt werden. nvidia hat sli von 3dfx "GEKLAUT", klar, dass das schneller geht... |

GEKAUFT!! nVidia hat es von 3dfx gekauft!

Crossfire ist der größte sch****: nVidia SLI ist sehr schnell ausgereicht und mit den Treibern werden immer mehr Spiele unterstützt.

Ihr redet Crossfire so schön, dabei ist es noch garnet draussen. Bin mal gespannt wie kompatibel das wird.

Und was ist mit ATIs Chipsatz?? Da habt ihr wohl keine Gegenargumente.

Crossfire hat schon den fetten Nachteil, das man eine spezielle "Crossfire"-Karte kaufen muss. Bei nVidia kann ich die beiden Karten jederzeit wieder getrennt verwenden. Crossfire-Karten laufen nicht alleine.

Und wie nVidia schon sagte: Crossfire wurde ruckzuck beim Kaffee aufn Blatt Papier geschmiert um nVidia paroli zu bieten.

Gebt es auf! nVidia hat heute schon dass, was ATI innem halben Jahr als Beta aufn Markt schmeisst :lol:

-- Veröffentlicht durch ErSelbst am 15:06 am 20. Sep. 2005

1. in wie weit sich das nv sli vom 3dfx sli unterscheidet, weiß ich nicht, weil ich mich nunmal für 2 graka technologie nicht wirklich interessier... das prinzip ist doch gleich oder nicht? bei ati ist das prinzip ja schon etwas anders. |

Bei 3DFX wurden immer abwechseln ganze Bilder berechnet und mit 2 V2- Karten konnte man in 1024er Auflösung zocken. Mit einer ging max. 800*600

Bei NV wird Dynamisch die Last für die einzelnen Bilder verteilt - eine berechnet oben, eine unten - je nach bildinhalten berechnet eine mal ein Bild fast ganz und die andere fast garnix, mal andersrum, mal 50:50 ...

-- Veröffentlicht durch N omega G am 14:34 am 20. Sep. 2005

Zitat von skynet um 13:07 am Sep. 20, 2005

1. falsch, das einzige was 3DFX SLI mit NV SLI gemein haben, ist der name, dei technologie ist ne komplett andere... soviel sollte man schon wissen wenn man stänkern will! :kidding: 2. NV macht das gleiche was ATI auch macht, die geben sich da beide nix... gibt nämlich auch schöne folien von ATI. :popo: 3. musste ja auch net. |

1. in wie weit sich das nv sli vom 3dfx sli unterscheidet, weiß ich nicht, weil ich mich nunmal für 2 graka technologie nicht wirklich interessier... das prinzip ist doch gleich oder nicht? bei ati ist das prinzip ja schon etwas anders.

2. irgendwie hab ich von ati sowas nie gelesen oder haste was? würde das sehr gerne lesen!

3. hast recht, ich muss mich nicht an benchmarkpunkten aufgeilen ;)

-- Veröffentlicht durch kammerjaeger am 13:26 am 20. Sep. 2005

Zitat von Paseoboy um 13:19 am Sep. 20, 2005 Ein Bild sagt mehr als 1000 Worte! |

Meinst Du den Grafikfehler/Streifen? :lol:

-- Veröffentlicht durch Paseoboy am 13:19 am 20. Sep. 2005

Ein Bild sagt mehr als 1000 Worte!

-- Veröffentlicht durch skynet am 13:07 am 20. Sep. 2005

Zitat von N omega G um 11:07 am Sep. 20, 2005 1. dass crossfire paar probleme am anfang hat, ist ja wohl klar, das ist eine NEUE technologie und die muss erst entwickelt werden. nvidia hat sli von 3dfx "GEKLAUT", klar, dass das schneller geht... 2. mir ist ja eigentlich die politik von firmen etc egal, hauptsache der preis und die leistung stimmt, aber so langsam muss ich mir echt überlegen, ob ich nicht von nv abstand halte. intel hats schon geschafft, nv ist mit sowas auf dem besten weg dahin, wenns nicht schon zu spät ist... PS ich steck mir trotzdem keine 2 karten in den rechner, obs jetzt sli oder crossfire ist :thumb: |

1. falsch, das einzige was 3DFX SLI mit NV SLI gemein haben, ist der name, dei technologie ist ne komplett andere... soviel sollte man schon wissen wenn man stänkern will! :kidding:

2. NV macht das gleiche was ATI auch macht, die geben sich da beide nix... gibt nämlich auch schöne folien von ATI. :popo:

3. musste ja auch net.

-- Veröffentlicht durch DexterDX1 am 11:36 am 20. Sep. 2005

Also bei 1600*1200 macht mein Monitor eh nur noch 75Hz, bei höheren Auflösungen wird es nicht besser.

Klar bei TFTs muss man nur 60 bis 72/75Hz haben, aber ich möchte die marktrelevante Menge Zocker sehen, die ein TFT mit einer größeren Auflösung haben.

Mein Monitor ist übrigens ein Philips 109b40 und als ich den kaufte, gab es in der 19-Inch-für-260-Euro-Klasse keine Alternative, auch nicht bei TFTs.

SLI ist meiner Meinung nach gut, um bei 1280*1024 (was die meisten TFTs, die zum Zocken genutzt werden ja haben, bzw. in absehbarer Zeit haben werden) die Qualität hochzuschrauben. Damit meine ich Kantenglättung und Texturfilterung genauso wie alternative oder zusätzliche Rendermodi (rechenintensivere Shader/HDR).

-- Veröffentlicht durch kammerjaeger am 11:25 am 20. Sep. 2005

Zitat von N omega G um 11:07 am Sep. 20, 2005 PS ich steck mir trotzdem keine 2 karten in den rechner, obs jetzt sli oder crossfire ist :thumb: |

So siehts aus und so ist es auch im Massenmarkt.

Natürlich würden viele Menschen gerne Ferrari oder Porsche fahren, aber kaufen tun sie dann doch einen Golf, egal ob der neue Ferrari 30PS mehr oder weniger hat als der neue Porsche.... ;)

-- Veröffentlicht durch N omega G am 11:07 am 20. Sep. 2005

1. dass crossfire paar probleme am anfang hat, ist ja wohl klar, das ist eine NEUE technologie und die muss erst entwickelt werden.

nvidia hat sli von 3dfx "GEKLAUT", klar, dass das schneller geht...

2. mir ist ja eigentlich die politik von firmen etc egal, hauptsache der preis und die leistung stimmt, aber so langsam muss ich mir echt überlegen, ob ich nicht von nv abstand halte. intel hats schon geschafft, nv ist mit sowas auf dem besten weg dahin, wenns nicht schon zu spät ist...

PS ich steck mir trotzdem keine 2 karten in den rechner, obs jetzt sli oder crossfire ist :thumb:

-- Veröffentlicht durch Henro am 10:53 am 20. Sep. 2005

jo denke auch das der großteil 17er-19er TFTs haben wird ... also finde ich auch das 1600x1200 erstmal völlig ausreichend ist.

-- Veröffentlicht durch Ossi am 10:17 am 20. Sep. 2005

Zitat von skynet um 10:17 am Sep. 20, 2005

wer GTX SLI hat spielt sicherlich nicht nur bis 1600*1200. :blubb: |

-- Veröffentlicht durch skynet am 10:17 am 20. Sep. 2005

Zitat von Ossi um 10:14 am Sep. 20, 2005 Ich will mal sehen wer über 1600*1200 spielt :noidea: |

wer GTX SLI hat spielt sicherlich nicht nur bis 1600*1200. :blubb:

-- Veröffentlicht durch Ossi am 10:14 am 20. Sep. 2005

Ich will mal sehen wer über 1600*1200 spielt :noidea:

-- Veröffentlicht durch Henro am 9:12 am 20. Sep. 2005

also das nvidia sowas macht und das es meißt lächerlich ist haben se ja schon in der vergangenheit bewiesen ... is ja nicht die erste präse die so ist.

Alles andere ist nur spekulation und man wird abwarten müssen was geht wenn die 520er serie drausen ist und was crossfire dann bringt.

-- Veröffentlicht durch skynet am 0:32 am 20. Sep. 2005

Zitat von razzzzia um 23:38 am Sep. 19, 2005 hehe...gibts eigentlich mittlerweile mal verlässliche Daten, wieviel Crossfire mehr bringt? SLI is ja zum benchen ganz nett, aber beim zocken teilweise echt lächerlich im Leistungszuwachs für die Kohle... Warscheinlich bringt Crossfire einfach effektiv mehr hinten raus und die Marketing-Hanseln bei Nvidia sch****en sich jetzt ein... *gg* |

wohl kaum, crossfire läuft noch nichtmal richtig, darum wurde der launch auch vom 15.9. auf den 6.10. verschoben. :lol:

ok, wieder zuviel verraten, aber ich konnte es mir nicht verkneifen! :biglol:

-- Veröffentlicht durch skynet am 0:31 am 20. Sep. 2005

Zitat von BDKMPSS um 23:11 am Sep. 19, 2005 klingt für mich sehr nach panik, desweiteren finde ich das bild ohne HDR um einiges realistischer und auch "schöner". und noch was historisches: es wird genau werden wie früher mit dem Kyro2(:godlike:²): der DAU hat SLI und der Pro hat Crossfire, weils einfach durchdachter ist und mit dem 520 auch alles bietet, was NV auf der Ati HP als "out of date" brandmarkt |

das bild ohne HDR sieht einfach nur unecht und schlecht aus...

aber probiere nur dein rotes sinkendes schiff schön zureden.... :lol:

p.s. der pro hat SLI, schon aus dem grund weil man damit auch auflösungen über 1600*1200 @ 60Hz fahren kann. :kidding:

-- Veröffentlicht durch kammerjaeger am 0:16 am 20. Sep. 2005

Zitat von BDKMPSS um 23:11 am Sep. 19, 2005 klingt für mich sehr nach panik, desweiteren finde ich das bild ohne HDR um einiges realistischer und auch "schöner". |

Nicht nur das. Ich frage mich auch, was CrossFire mit SM3 und HDR zu tun haben soll? :noidea:

Und SLI-Antialiasing mag ja mit allen Spielen funzen, aber leider bringt SLI nicht bei allen Spielen Performance-Gewinn. ;)

Und warum vergleicht man seine 7800GTX SLI mit X850 CrossFire? Hat man etwa Schiss vor dem Nachfolger, welcher ja der eigentlich Konkurrent wäre? Wenn schon, dan muß man 6800 SLI mit X800 CrossFire vergleichen...

Mannomann, müssen die es nötig haben. :blubb:

-- Veröffentlicht durch BDKMPSS am 23:44 am 19. Sep. 2005

Zitat von ErSelbst um 23:37 am Sep. 19, 2005

von ATI hört man in ein paar Monaten nix mehr? :noidea: |

ich meine eher auf das dagegen Hetzen bezogen

aber wenn das so weiter geht, sehe ich schwarz für ati: selbst mein vater weiß was SLI ist und wollte sich das holen und gegen seine Parhelia tauschen. gott sei dank konnte ich ihm das austreiben: SLI für jemanden der nichtmal ne CD/DVD brennen kann und nur bildbearbeitung macht...

-- Veröffentlicht durch razzzzia am 23:38 am 19. Sep. 2005

hehe...gibts eigentlich mittlerweile mal verlässliche Daten, wieviel Crossfire mehr bringt?

SLI is ja zum benchen ganz nett, aber beim zocken teilweise echt lächerlich im Leistungszuwachs für die Kohle...

Warscheinlich bringt Crossfire einfach effektiv mehr hinten raus und die Marketing-Hanseln bei Nvidia sch****en sich jetzt ein... *gg*

(Geändert von razzzzia um 23:39 am Sep. 19, 2005)

-- Veröffentlicht durch ErSelbst am 23:37 am 19. Sep. 2005

Zitat von BDKMPSS um 23:11 am Sep. 19, 2005 und noch was historisches: es wird genau werden wie früher mit dem Kyro2(:godlike:²):[...] |

von ATI hört man in ein paar Monaten nix mehr? :noidea:

-- Veröffentlicht durch BDKMPSS am 23:11 am 19. Sep. 2005

klingt für mich sehr nach panik, desweiteren finde ich das bild ohne HDR um einiges realistischer und auch "schöner".

und noch was historisches:

es wird genau werden wie früher mit dem Kyro2(:godlike:²):

der DAU hat SLI

und

der Pro hat Crossfire, weils einfach durchdachter ist und mit dem 520 auch alles bietet, was NV auf der Ati HP als "out of date" brandmarkt

-- Veröffentlicht durch Falcon am 22:53 am 19. Sep. 2005

lol, das is ja mal nur geil :lol:

-- Veröffentlicht durch QnkeI am 22:35 am 19. Sep. 2005

Nvidia verknüpft seit einiger Zeit mit der so genannten SLI-Technologie zwei Grafikkarten, um die Leistung zumindest theoretisch zu verdoppeln. ATI kontert noch in diesem Monat mit Crossfire, das eine ähnliche Funktionalität bietet. Dies scheint Nvidia nun ernsthaft zu beunruhigen.

Eine interne Präsentation des nach eigenen Worten führenden Grafikchip-Herstellers kritisiert den SLI-Pendanten des Konkurrenten ATI in Grund und Boden. Nicht verschont werden unter anderem die lange Zeitspanne von der Ankündigung bis zur Veröffentlichung, die Auflösung von nur 1600x1200 sowie die nicht vorhandene Unterstützung des Shadermodells 3.0.

Wie viel besser die eigene SLI-Technik in der Präsentation wegkommt, bedarf keiner Erwähnung. Auch ist fragwürdig, ob das Blatt mit dem „internen“ Flamewar tatsächlich geleakt ist, oder ob die Veröffentlichung mit Absicht geschah. Schließlich gab es einen ähnlichen Fall schon 2002, damals allerdings gegen den Kyro-2 Chipsatz von STMicroelectronics.

Quelle:

nVidia-Präsentation bei techpowerup.com

Einfach nur geil :godlike:

WinFuture

(Geändert von QnkeI um 16:43 am Sep. 20, 2005)