-- Veröffentlicht durch kammerjaeger am 23:11 am 12. Jan. 2010

So, die letzten Tage gingen mehrere Lieferungen ein, von der 5770 über 5850 bis zur 5870. Inzwischen hat sich also die Verfügbarkeit der Karten stark gebessert und selbst die Preise sind bei manchen Modellen trotz des erstarkten Dollars zurück gegangen.

Btw.: Morgen bekomme ich die ersten HD 5670 (obwohl der offizielle Launch für den 21.01. angesetzt ist...). Laut den ersten Vorberichten soll sie zwar in der Leistung kein Überflieger sein (knapp unter 4770), aber dafür sehr sparsam. So ist mit einem Idle-Verbrauch von 10W zu rechnen und Load keine 50W. Die Karte hat nicht einmal einen PCIe-Anschluss!

Preise werden wohl bei ca. 75,- für die 512MB-Version beginnen und <100,- für die 1GB-Version.

Ich werde die Tage mal berichten... ;)

-- Veröffentlicht durch kammerjaeger am 22:59 am 5. Jan. 2010

Ich hab heute welche bekommen, aber leider teurer als vorher eingekauft und trotzdem schon wieder alle weg...

-- Veröffentlicht durch Rulinator am 22:58 am 5. Jan. 2010

ab wann sind 5850 und 5870 endlich verfügbar? gibt ja kaum shops wo sie zu humanen preisen zu haben sind... :noidea:

-- Veröffentlicht durch k3im am 16:11 am 2. Jan. 2010

Welche 5770 würden sich denn am besten eignen? Die im alten gewand mit dem Kühler der das PCB komplett abdeckt oder diese new Design Dinger? Tun die sich was Temp mässig oder haben ein anderes Layout?

ÄDIT

Hat sich erledigt. :) Allerdings könnte man ja echt 2 Vapor-X nehmen. Der Bios Flash sollte ja hoffentlich kein Problem sein. Kann man direkt ein OC Bios drauf machen und zwei Fliegen mit einer Klappe schlagen :punk:

Gibbet schon ein Tool womit man 5xxx er Biose editieren kann?

(Geändert von k3im um 13:18 am Jan. 3, 2010)

-- Veröffentlicht durch k3im am 11:56 am 2. Jan. 2010

Puh! Du meintest die Vapor-X.

Ich dachte erst die Club3D :) Dann eben zwei andere 5770er. Wäre dann ja auch wieder billiger. Vieleicht zwei Powercolor oder so. Ist ja im Endeffekt egal. Die tun sich ja nix.

Aber erst mal abwarten was die nächste Woche so an Cypress bringt :punk:

-- Veröffentlicht durch smoke81 am 11:49 am 2. Jan. 2010

Gerade bei diesem Modell gibt es z.Zt. Probleme: HWL

-- Veröffentlicht durch k3im am 8:38 am 2. Jan. 2010

Zitat von kammerjaeger um 23:45 am Jan. 1, 2010 Btw.: Nächste Woche sollte ein größerer Schwung an 58xx-Karten kommen. |

:moin:

Ich wollte eh noch bis Mitte Januar warten. Aber dann wirds mir irgendwann auch zu blöd. Habe letzte Woche mal bei HWV eine von Club3D bestellt. Ich wollte eh dieses Modell haben. Jetzt hoffe ich natürlich das sich alle nach wie vor auf die Asus Karte und alle mit Dirt2 Coupon stürzen, so das ich gute Chancen habe nächste Woche. Abwarten.

Aber wenn das nix wird ist doch so ein CF aus zwei 5770 gar nicht so schlecht. Gerade wenn man 1920x1200 spielt wenn ich das richtig verstehe. Vielleicht zwei Vapor-X :lol:

-- Veröffentlicht durch kammerjaeger am 23:45 am 1. Jan. 2010

Zitat von k3im um 23:13 am Jan. 1, 2010 Sind die Mikroruckler so schlimm das sie, trotz Verbesserung, immer noch erwähnenswert sind? |

Das Thema Mikroruckler wird in meinen Augen völlig überbewertet. Die können selbst in der Theorie nur bei Frameraten <50fps auftreten, in der Praxis wird man sie erst bei max. 35-40fps antreffen. Nur wie hoch muss man Auflösung und Settings schrauben, um mit einem leistungsfähigen CF in diese Bereiche abzurutschen? Im von Dir verlinkten Test kommt man einzig bei Crysis:Warhead so tief, dass theoretisch Mikroruckler auftreten könnten.

Oft achtet man auch bei CF-Systemen bewusst auf kleine Hakler, die aber teilweise Engine-bedingte Nachladeruckler sind, aber dann gerne als Mikroruckler interpretiert werden. ;)

Btw.: Nächste Woche sollte ein größerer Schwung an 58xx-Karten kommen.

-- Veröffentlicht durch k3im am 23:13 am 1. Jan. 2010

Mal ne generelle Frage. Habe mich gefragt ob ein CF System aus 2 5770ern Sinn macht bei der momentanen Verfügbarkeit der 5870. Das System positioniert sich auch Leistungsmässig zwischen xx50 und xx70 und ist ja wikrlich auch, was die momentanen Preise angeht, mit ca 280 €uro noch im Rahmen und preislich zwischen 50 und 70. Alleridngs erzählen die hier wieder von mikrorucklern. Die haben sich wohl verbessert aber sind immer noch da. Hab enie ein CF oder DualGPU Karten System besessen. Kann mir jemand was dazu sagen? Sind die Mikroruckler so schlimm das sie, trotz Verbesserung, immer noch erwähnenswert sind?

Frohes Neues!!!

-- Veröffentlicht durch rage82 am 15:19 am 27. Nov. 2009

es ist schon ziemlich interessant, dass man mit niedriger temperatur auch gleich den geldbeutel schonen kann.

doof von scythe das der lüfter saugend aber keine gute figurmacht und das drehen wohl ein wenig aufwand bedeutet.

-- Veröffentlicht durch kammerjaeger am 8:26 am 27. Nov. 2009

Und das Karten "aufwärmen" bei Nvidia geht fleißig weiter: klick

Wenn man nichts Neues hat, gibt man dem alten Kind einen neuen Namen... :lol:

-- Veröffentlicht durch AssassinWarlord am 20:25 am 26. Nov. 2009

sinnlos -.-

erst heiß machen dann stehen lassen :-(

ist ja wie mit den Weibern...:lol:

-- Veröffentlicht durch smoke81 am 11:10 am 26. Nov. 2009

Ist nicht der Fall, warten wir mal die nächste(n) Generation(en) ab ;)

-- Veröffentlicht durch AssassinWarlord am 18:42 am 25. Nov. 2009

mal eine andere Frage...hieß es nichtmal, das die 5970 die erste Graka sein sol mit einem Echten DualCore GPU? also wo keine zwei getrennte GPUs auf einem PCB verbaut werden, sondern wie beim Core2Duo die beiden Cores in einem DIE vereint sind?

habe da mal was darüber gehört, aber anscheint war das auch nur ein mythos :-(

-- Veröffentlicht durch k3im am 12:14 am 25. Nov. 2009

Uuups. Hatte nur bei Snogard geguckt. Ich bin trotzdem sauer :) Die sollen die Chips nicht für so ein Zeug verbraten sondern 5870er raushauen.

-- Veröffentlicht durch rage82 am 11:37 am 25. Nov. 2009

insgesamt 5 händler haben die 5970 lagernd.

geizhals

-- Veröffentlicht durch k3im am 10:52 am 25. Nov. 2009

Die Händler sind so peinlich. Null verfügbarkeit bei 5850/70 aber Hauptsache die 5970 listen. Das die gar nicht merken wie die sich mit zum Affen machen. Die Karten wird es dann so um Karneval rum geben :noidea:

Tschuldigung aber musste meinem Unmut Luft machen.

-- Veröffentlicht durch smoke81 am 16:32 am 24. Nov. 2009

Die Leistung ist eine physikalische Größe, die relativ konstant bleibt. Ob sie unter anderen Umgebungen noch ausreicht, ist ein anderes Thema.

-- Veröffentlicht durch kammerjaeger am 0:25 am 24. Nov. 2009

Zitat von smoke81 um 0:14 am Nov. 24, 2009 Die Kühlleistung ist also nicht von der Temperatur der Luft im Raum abhängig |

Jein. Wenn der Kühler es schafft, die Karte bei "normaler" Umgebungs-Temperatur (sagen wir mal 35 Grad) knapp unter einem kritischen Wert zu halten, dann würde dieser Wert bei 10 Grad mehr Umgebungstemperatur auch um 10 Grad steigen und so evtl. den kritischen Punkt überschreiten. Während also bei 35 Grad die Kühlleistung als ausreichend anzusehen ist, ist sie es bei 45 Grad dann nicht mehr.

Die Ausführung mit Delta-T ist ja korrekt, aber eben nur solange, wie ich mich nicht in der Nähe der max. zulässigen Temp befinde...

-- Veröffentlicht durch smoke81 am 0:14 am 24. Nov. 2009

Wenn der Kühler 400W abführen kann, dann kann er das auch bei 45°C warmer Luft. Leider werden in vielen Kühlertests oder im privaten Vergleich absolute Temperaturen der GPU angegeben. Korrekter wäre es, ein Delta T anzugeben. Dieses Delta T dürfte näherungsweise konstant bleiben bei etwas abweichender Umgebungstemperatur (+/- 10°K) und bezeichnet den Unterschied zwischen GPU-Temperatur und Umgebungstemperatur.

Die maximale Kühlleistung ist also im Rahmen normaler Bedingungen immer gleich (400W), sowie annähernd das Delta T. Nur die GPU-Temperatur wird annähernd linear ansteigen bei höheren Ausgangstemperaturen.

Die Kühlleistung ist also nicht von der Temperatur der Luft im Raum abhängig, wohl aber z.B. von Staub im Lüfter oder zwischen den Lamellen des Kühlers.

-- Veröffentlicht durch kammerjaeger am 23:00 am 23. Nov. 2009

Zitat von smoke81 um 14:53 am Nov. 23, 2009 400 Watt Abwärme bleiben erstmal 400W, egal ob ein Gehäuse gut oder schlecht belüftet ist. |

Leider nicht! Schließlich macht es einen Unterschied, ob ich den Wärmeaustausch mit 25 Grad warmer Luft vornehmen muss oder mit 45 Grad warmer Luft. Je wärmer die Umgebung, desto schlechter die max. Kühlleistung bei voller Drehzahl.

Ich denke, dass der Kühler deshalb mit 400W Kühlleistung propagiert wird, weil er dann nie mit max. Drehzahl arbeiten muss, was unnötigen Lärm verhindert. Und man hat Reserven für den Sommer oder leicht verstaubte Lüfter. Ist schon krass, was man in der täglichen Praxis so an Wollmäusen aus manchen Grafikkarten zieht, die erst wenige Monate im Einsatz sind. Da wundert es nicht, wenn einige Kartenhersteller ihre Lüftersteuerung nicht ultra-silent abstimmen, obwohl es bei sauberem Lüfter möglich wäre...

-- Veröffentlicht durch smoke81 am 19:36 am 23. Nov. 2009

Schnellere und effizientere (Stromverbrauch beim Schaltvorgang) Transistoren werden erforscht und kommen noch bzw. wurden diese in der Vergangenheit kontinuierlich verbessert.

Eine geringere Anzahl an Transistoren wird es aber kaum geben können, da jeder Algorithmus und jedes Feature in einem Rechner eine Mindest-Anzahl an Transistoren braucht, um diese korrekt darstellen zu können. Es wird auf jeden Fall die nächsten Jahrzehnte noch stark ansteigende Transistorzahlen geben, bis wir vielleicht in der Forschung auf etwas völlig anderes stoßen ;)

-- Veröffentlicht durch AssassinWarlord am 17:31 am 23. Nov. 2009

man darf ja nicht vergessen, das die graka sich auch etwas strom vom PCIe Buss genehmigen kann, glaube max. 75W waren das was der PCIe Bus hergibt?

aber solche hohen ströme sind schon irgendwie krass. ich weis nicht so recht, aber das kann doch unmöglich der richtige weg sein, oder? mehr leistung bei stärkerer abwärme...klar, gut möglich das sie mehr leistung frisst, aber denke da muss eine andere architektur her, die einfach weitaus effizienter arbeitet.

ist ja wie mit den Endstufen damals...damsl gabs nur Class A Stufen, die haben eine mörderrische abwärme produziert und einen strom gefressen um mal 100W rauszuhauen, heutzutage gibt es Class H stufen und sowas, die hauen gleich mal 500W raus bei der gleichen stromaufnahme, bei deutlich geringerer abwärme...

sowas fehlt irgendwie noch in der Computertechnik.

Und dabei arbeiten die Transistoren schon im Digitalem betrieb, müssen also nicht "halboffen" sein wo extreme verluste entstehen (wie damals mit den alten Class A Analogendstufen...die heutigen ClassAB ist was anderes, aber sehr ähnlich)

weis nicht, ob das phantasiedenken von mir ist, aber ich sehe darin keinen sinn, einfach immer mehr transistoren reinzustecken die schön parallel ihre arbeit vollrichten. Sollte die forschung nicht eher dahin gehen, schnellere, effektivere transistoren zu entwickeln? das man mit der Transistoranzahl runterkomm?

-- Veröffentlicht durch rage82 am 16:14 am 23. Nov. 2009

das ist (eigentlich ja nicht) definitionssache, je nachdem wie die tdp vom wertgeber gesehen wird.

der eine legt sie als maximale verlustleistung aus, für die der kühler die anfallende wärme abtransportieren kann. der nächste nimmt den wert tatsächlich als äquivalente wärmeleistung.

damit haben wir schonmal den ersten punkt, über den wir streiten können ;)

aber das ist gar nicht so wichtig, weil ich denke du hsat tatsächlich recht und zwar ist mir gerade eingefallen, furmark und die 4870er. die sind ja desöfteren gestorben zu beginn. hier scheint amd endlich den korrekten weg einzuschlagen und muss nicht mehr per treiber (was sich auch nocheinfach überlisten lässt) gegensteuern.

-- Veröffentlicht durch smoke81 am 14:53 am 23. Nov. 2009

400 Watt Abwärme bleiben erstmal 400W, egal ob ein Gehäuse gut oder schlecht belüftet ist.

Dass mehr als die 25A kein Problem sind, sieht man auch an der HD4870 X2, die im Furmark bereits an der 400W-Grenze nagt. Unter Spielen sind es gute 300W. Wer diese Karte übertaktet, kommt bei Spielen locker über 350W und unter Furmark bis auf 450W...

Die Leistung bereitzustellen ist bei einem guten Netzteil wohl weniger das Problem. Vielmehr sind es die Bauteile auf der Grafikkarte und die entsprechenden Leiterbahnen der Platine, die für die Spannungsversorgung zuständig sind, die am ehesten über den Jordan gehen. Auch die GPU selber ist bei einigermaßen passender Kühlung sehr robust.

-- Veröffentlicht durch rage82 am 14:25 am 23. Nov. 2009

da sich auf den 3 stromliefernden anschlüssen aber sowieso nur 25A tummeln dürfen, macht es amd's vorgehen nur um so verwirrender.

erst behaupten man habe sich gegen 2 8-polige stecker entschieden, weil es da keine offizielle spezifikation gibt, dann aber den kühler dahingehend auslegen und bewerben.

gut, man kann das natürlich auch anders auslegen, womit wir bei schlecht belüfteten gehäusen landen, aber ich denke auch nicht, das es so gemeint ist.

(Geändert von rage82 um 14:29 am Nov. 23, 2009)

-- Veröffentlicht durch smoke81 am 14:16 am 23. Nov. 2009

Dann sollten aber die "Profis" auch die Möglichkeit haben, dieses Feature abzuschalten. Die Garantie geht so oder so flöten.

Außerdem wirbt AMD damit, dass der Kühler dieser Karte auf 400W TDP ausgelegt sei...

-- Veröffentlicht durch kammerjaeger am 16:38 am 22. Nov. 2009

Ist doch Klasse! So kann selbst der letzte Super-DAU seine Karte maximal übertakten, ohne Angst um sie haben zu müssen!

Das "Schweigen" um dieses Feature kann ich mir nur so erklären, dass AMD/ATI selbst wenig Zeit hatte, es ausführlich genug zu testen, um sicher zu gehen, dass es auch korrekt greift. So wollte man lieber nichts versprechen, was man später nicht halten kann (wie damals die zu schwache Umsetzung der möglichen Stromspar-Mechanismen bei 4850/4870).

-- Veröffentlicht durch rage82 am 14:22 am 22. Nov. 2009

so, die hd5970 wurde ja nun ausgiebig getestet, insgesamt nette karte, allerdings erscheint mir das vorgehen von amd bei der karte seltsam.

ht4u haben auf seite 18 geschrieben was sie denken und das mehr oder weniger von amd bestätigit bekommen. diese funktion finde ich persönlich super, auch wenn sie oc bei zukünftigen spielen vielleicht etwas einschränkt. aber scheinbar will sich amd die overclocker für die nächsten 2-3 monate nicht als kunden vergraulen und teilt über die funktion nichts mit.

es gibt sogar ein overvoltage-tool für die presse und das wo man extra selektierte chips verbaut um die tdp von unter 300w realisieren zu können. und wenn dann eine leistungsüberwachung bei 300w die graka abschaltet oder runtertaktet, frag ich mich was das soll. bisher ist der furmark natürlich der einzige der ohne overvolting an die 300w rankommt, aber mit oc hat ht4u bei bioshock schon 250w gemessen. man hebe mal die spannung an und warte was passiert...

seltsames vorgehen...

-- Veröffentlicht durch smoke81 am 11:23 am 9. Nov. 2009

Das ist natürlich doof, wenn man ausgerechnet eine spezielle Karte mit Übertaktungsfeatures hat und sich diese nicht übertakten lässt....

Dieses Risiko eines geringen Potentials hat man allerdings immer...

-- Veröffentlicht durch Henro am 2:01 am 9. Nov. 2009

das blöde an der sache ist ja das die 5770 durch die speicherbandbreiten limitierung jedes Mnz mehr speichertakt viel eher in mehrperformance umsetzt als gpu takt ... ich denke mal das durch die anhebung der gpu spannung die übertaktung des speichers auch nicht weiter gehen wird :(

Du hast aber mit dem was du sagt recht btw. stimme ich da mit dir überein das sich der ganze aufwand und das risiko in anbetracht der geringen möglichen mehrleistung nicht lohnt.

daher hab ich mich auch eigentlich schon mit den +100Mhz speichertakt übers Ati CCC abgefunden.

Allerdings hatte ich ja nun schon die asus karte die ja abweichend der ganzen hersteller vorgaben karten diese zusätzliche funktion bietet ;)

-- Veröffentlicht durch smoke81 am 0:23 am 9. Nov. 2009

AFAIK haben HD5850 und/oder HD5870 meistens 1,25V anliegen. Bis 1,3V wäre für die GPU absolut kein Problem, vielleicht sogar 1,4V bei guter Kühlung...

Jedoch ist die Spannungsversorgung und das PCB der HD57xx-Serie wesentlich abgespeckt, ich würde mir eher darum Sorgen machen, als um die GPU.

Ich würde es mal mit 1,25V probieren (nach der 10%-Faustregel sollte dies noch problemlos machbar sein). Wenn dann immer noch kein Zuwachs in der Übertaktungsfähigkeit sein sollte, dann limitiert etwas anderes oder die Einstellungen werden nicht übernommen.

Allerdings lohnt sich der ganze Aufwand für 5% Taktsteigerung bestimmt nicht.

Mittlerweile bin ich wieder etwas vom Graka-OC abgekommen, da mit Ausnahme der HD4850 und der X1900 AIW, alle aktuellen und letzten Karten (ab X800 Pro) nur Potential im Bereich von 5-10% hatten... das ist für mich zu wenig.

-- Veröffentlicht durch Henro am 23:29 am 8. Nov. 2009

So also ich konnte es natürlich nicht sein lassen und hab mit dem tweak-tool von asus gespielt bei meiner 5770.

Ohne spannungserhöhung und schon sehr schnell bei 850/1300 Mhz Schluss. Std. sind ja 850/1200 bei 1,125V GPU Spannung.

Leider ist auch mit 1,2V GPU Spannung bei meiner Karte nicht mehr drin. Zumindest nicht 900Mhz CPU Takt und/oder 1400Mhz Ram Takt was ich erst als lohnenswert betrachte bei der Spannungszugabe.

Fazit für mich also erstmal : Hat mir gar nix gebracht. Ich hab allerdings auch keinen Plan was man dem 40nm Chip zumuten kann ... vielleicht bin ich ja auch zu zaghaft.

-- Veröffentlicht durch k3im am 12:25 am 7. Nov. 2009

Zitat von k3im um 13:06 am Sep. 26, 2009

Genau das ist der Punkt. Auf jeden Fall will ich das Teil haben. Die Frage ist nur, wo vorbestellen? Alternate z.B. Listet das Teil mit 350 €uro. Da hat man zwar die Sicherheit das man nicht abgezockt wird aber de rPreis ist schon krass. Wo bestellt ihr vor? Oder gebt ihr das aus 10% Gründen nicht bekannt :lol: |

Zitat von spraadhans um 13:13 am Sep. 26, 2009 Wer jetzt zu den aktuellen Preisen vorbestellt ist ein seltener Schwachvogel, da die Vergangenheit gezeigt hat, dass die Preise vor Erscheinen eher zu hoch als zu niedrig kalkuliert waren. Aber macht mal, freut mich für die Shops und ATI. |

Hätte ich echt mal lieber die Kohle vorher locker gemacht.

-- Veröffentlicht durch bikerks am 23:13 am 6. Nov. 2009

^Danke für die Info. Gucke dann mal nach gebr. Karten. Gibt ja dann wüste,die auf 5970 umsteigen.

-- Veröffentlicht durch kammerjaeger am 22:46 am 6. Nov. 2009

Dann wirst Du auf lange Zeit bei Deiner aktuellen Karte bleiben müssen!

Die Preise für 5850/5870 sind um 20$ angehoben worden, die Marktknappheit hebt die Preise zusätzlich an. Auch die 5770 hat etwas angezogen.

Bei Nvidia sieht es auch nicht viel besser aus. GTX260 sind noch halbwegs zu bekommen, aber auch im Preis gestiegen. GTX275 sind nur in kleinen Stückzahlen und zu überhöhten Preisen verfügbar. Und was GTX280/285/295 angeht, so sind es bis auf wenige Einzelkarten, die aus minimalen restbeständen in den Markt tröpfeln, nur noch Karten, die irgendein Händler im Keller gebunkert hatte und jetzt für teures Geld an den Mann bringen will...

Lediglich die 4870 ist den preislichen Weg nach oben noch nicht gegangen und daher aktuell >100,- die Karte mit dem besten Preis/Leistungs-Verhältnis, sofern einem die Features und der geringere Verbrauch der 5770 egal sind und den Aufpreis von 30,- nicht wert. ;)

-- Veröffentlicht durch bikerks am 21:59 am 6. Nov. 2009

Zitat von k3im um 20:35 am Nov. 6, 2009 Es wird immer unverschämter. Die Preise steigen immer weiter für nicht lieferbare Karten. Alternate will mittlerweile 409 €uropas für ne Asus 5870 haben. |

-- Veröffentlicht durch rage82 am 21:30 am 6. Nov. 2009

nunja, zumindest die 5850 wurde offiziell im preis erhöht. was davon bei uns ankommt steht auf einem anderen blatt.

dennoch denke ich, dass bis fermi amd die preise ohne probleme aufrecht erhalten kann.

-- Veröffentlicht durch AssassinWarlord am 21:05 am 6. Nov. 2009

hätte man echt eine vorbestellen solen wo sie neu war...da wurden die für 280 angeboten xD

-- Veröffentlicht durch k3im am 20:35 am 6. Nov. 2009

Es wird immer unverschämter. Die Preise steigen immer weiter für nicht lieferbare Karten. Alternate will mittlerweile 409 €uropas für ne Asus 5870 haben. Zum bekloppt werden. Wer bestellt denn für den Preis bitte vor? Ich war ja bereit die 330 zu zahlen, aber so langsam hört es auf witzig zu sein.

-- Veröffentlicht durch Henro am 22:32 am 2. Nov. 2009

so also ich hab nun die 5770 von asus ... das tweak tool bietet leider nur spannungserhöhung für GPU nicht für den RAM :(

Mit mehr Spannung haben wohl schon welche 1Ghz Takt erreicht, aber was bringt mir das wenn der flaschenhals bei der Karte die Speicherbandbreite ist ? ;) Ich hab aber OC Mässig noch nix versucht da sie an sich schnell genug ist. Nur unter AA bricht sie halt ein wenig ein und ich dachte das könnte man mit mehr Speichertakt noch gerade bügeln.

[Edit]

Also ohne Spannungserhöhung, also out of the box sind leider nichtmal 900/1400 drin :(

(Geändert von Henro um 19:47 am Nov. 4, 2009)

-- Veröffentlicht durch kammerjaeger am 8:12 am 30. Okt. 2009

Zitat von Henro um 7:30 am Okt. 30, 2009 so schade ... die bestelle 5770 war dann natürlich nicht mehr beschaftbar :( |

Zitat von kammerjaeger um 18:53 am Okt. 23, 2009 Für 130,- kann sie aktuell niemand einkaufen, ich bezweifle daher noch, dass sie am 27. auch wirklich kommt... |

Da war wohl ein Händler zu optimistisch mit der Preisentwicklung... ;)

-- Veröffentlicht durch cheech2711 am 8:03 am 30. Okt. 2009

Lagerbestand 3 Powercolor 5770

-- Veröffentlicht durch Henro am 7:30 am 30. Okt. 2009

so schade ... die bestelle 5770 war dann natürlich nicht mehr beschaftbar :(

Aber mitlerweile gibts die Asus 5770 beim lokalen Händler für 150. Die bietet ja auch noch dieses Tweak Feature mit Spannungserhöhung. Damit sollte sich der Knick in der Speicherbandbreite dann bei Bedarf ausbügeln lassen.

-- Veröffentlicht durch bikerks am 23:23 am 26. Okt. 2009

Danke ihr beiden. :thumb: Nennt mich fauler Hund ;) - Hab irgendwie heute zuviel über die 5870 gelesen :noidea: und bin blind.

Beschlossen -Das lange Schiff kommt hier rein.

Habe auf einigen Panzer/Waldmaps 30-40FPS bei 4-16/16 HQ alle Details auf max.,Supersampling usw. Damit müsste jetzt erstmal Schluss sein.

- Wenn ich 60-70FPS bei Superauflösung bekomme,werden sich einige in der Ferne wundern :lol:

Also die 190-ü 200FPS(Tests) kommen eh nicht hin,weiß ich ja. Ist ja auch nur zum parallelen Vergleich der Karten.

Sollte hinkommen mit 20-25FPS Zunahme(Meine GTX260OC ist so schnell wie eine 280er)

Endlich seh ich mal Unterschiede.GTX280/285 usw hatte sich nie gelohnt.

Aus 5-10km seh ich nun die Pixelchenpanzerlein,nur die meisten mich nicht :lol:

Kanns kaum abwarten. Spiel das schon seit einigen Jahren,weil schwerer realistischer Egoshoter. Und immer wieder fehlten diese 15-20FPS :godlike:

(Geändert von bikerks um 23:52 am Okt. 26, 2009)

-- Veröffentlicht durch k3im am 23:03 am 26. Okt. 2009

Google eben... I love it :)

-- Veröffentlicht durch k3im am 22:59 am 26. Okt. 2009

Sowas?

Kann man irgendwie sogar die Auflösung verändern.

-- Veröffentlicht durch kammerjaeger am 22:58 am 26. Okt. 2009

-- Veröffentlicht durch bikerks am 22:38 am 26. Okt. 2009

Ab wann ist denn wieder mit ca. 320 Euro für die 5870 zu rechnen ?

350(momentan) hört sich irgendwie nach 700 D-Mark an :lol:

Dann hab ich endlich nach gefühlten 100 Jahren wieder was von AMD in meinem Gehäuse. GTX260OC bisher...wenn schon denn schon gleich die Große. :progen: Kommt das Asus-Bios drauf , Wasserkühler und dann voll Stoff. Ich hab jetzt einfach Lust auf was unvernünftiges.

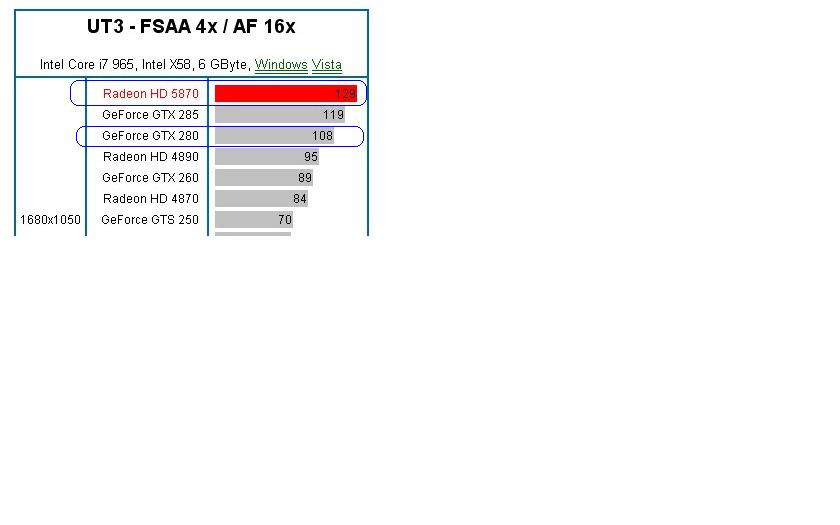

PS: Nicht lachen. Spiele Red-Orchestra(alter Unreal Engine) , dafür aber alles auf max. was geht(1680er Auflösung). Vergleiche Karten immer mit UT3 Benches. Evtl. rüste ich auch noch mal auf einen 1920er Moni um. Bin aber mit dem derzeitigen,wegen seiner 1a Schwarzwerte zufrieden.

UT3 Benches für die großen Atis irgendwo greifbar? Hab nix gefunden.

(Geändert von bikerks um 22:46 am Okt. 26, 2009)

-- Veröffentlicht durch rage82 am 9:31 am 26. Okt. 2009

heute war eine 5770 für 134,90 bei zack-zack... für etwa 30 minuten ;)

-- Veröffentlicht durch kammerjaeger am 13:52 am 25. Okt. 2009

Zitat von spraadhans um 10:53 am Okt. 25, 2009 @KJ: Okay, du vergleichst die 1 GB Variante der 4870, die aber zur Zeit sogar noch einen Tick schneller als die 5770 ist. Nimmt man aber die 512er, welche für aktuell ab 95,- den Besitzer wechselt, dann steht ein Aufpreis von knapp 40,- im Raum. |

Natürlich vergleiche ich sie mit der 1GB-Variante, denn wer die 512MB-Version kauft, der kann auch bei der 4850/4770/5750 bleiben! Dort, wo 512MB reichen, sind auch diese Chips noch schnell genug (max. 1680x1050 und je nach Spiel mittlere bis hohe Details und kein 8xAA).

Auch wenn die 4870 512MB eine hohe Rohleistung hat, so ist sie aktuell eher uninteressant. Mit der 4770 spart man Strom und Geld (15-20,- Kaufpreis und ca. 35W idle sowie 75W load), die Leistung ist für 512MB völlig ausreichend.

Nur wem der Strom egal ist oder eine zweite Karte für ein CF mit einer bestehenden 4870 sucht, der bekommt mit der 4870 eine sehr starke Karte für kleines Geld.

Für alle anderen Käufer ist auf lange Sicht die 5770 die bessere Wahl und holt den Mehrpreis bei vielen Usern schon durch den Verbrauch locker wieder rein.

-- Veröffentlicht durch spraadhans am 10:53 am 25. Okt. 2009

@KJ:

Okay, du vergleichst die 1 GB Variante der 4870, die aber zur Zeit sogar noch einen Tick schneller als die 5770 ist.

Nimmt man aber die 512er, welche für aktuell ab 95,- den Besitzer wechselt, dann steht ein Aufpreis von knapp 40,- im Raum.

Allerdings ist der Unterschied im Verbrauch schon extrem, das muss ich zugeben.

Vielleicht verdeutlicht sich das besser am Beispiel der 5750, die wenig schneller als eine 4770 ist, dafür aber gleich mal 30,- teurer ist und außer DX11 und 1GB VRAM kaum Vorteile bringt...

Ich will die Karten nicht schlecht reden, ganz im Gegenteil AMD hat ganze Arbeit geleistet, nahezu auf allen Gebieten aber solange die günstigen Vorgängerkarten noch zu haben sind, fällt mir eine uneingeschränkte Kaufempfehlung schwer, CB übrigens auch (5750)

(Geändert von spraadhans um 13:27 am Okt. 25, 2009)

-- Veröffentlicht durch rage82 am 9:57 am 25. Okt. 2009

Zitat von k3im um 0:45 am Okt. 25, 2009 Im November soll ja wohl angeblich schon die 5950 oder wie das X2 Model heissen soll rauskommen. Ich finds langsam echt frech das es null Karten und wenn, dann nur zu horrenden Preisen gibt. Für den X2 release ist das single GPU Angebot echt mager. |

horrende preise? für die schnellste single gpu am markt? ich glaube doch eher wir sind hier mittlerweile ein wenig verwöhnt. man kann nur hoffen, das auch ati von den erhöhten preisen etwas sieht, denn die können es brauchen.

außerdem müssen auch graka-hersteller mit den erhöhten dram-preisen arbeiten, und die sind das beste was unserer it-welt in diesem jahr passiert ist ;)

-- Veröffentlicht durch kammerjaeger am 8:48 am 25. Okt. 2009

Natürlich ist die 4870 von der Leistung her der 5770 etwa ebenbürtig, das wird sich aber mit jedem DX11-Titel zugunsten der 5770 verschieben, da SM5.0 tatsächlich Performance bringt!

Der Unterschied im Verbrauch ist schon sehr deutlich, immerhin trennen die Karten idle über 50W und load über 40W (klick). Wenn der Rechner also 5-6 Stunden am Tag an ist, hat man schon nach einem Jahr den Mehrpreis von aktuell ca. 20,- (Tendenz bald fallend) nur durch den Verbrauch wieder raus... ;)

-- Veröffentlicht durch spraadhans am 8:29 am 25. Okt. 2009

Technisch sind die beiden MIdrange-Karten sicherlich interessant aber bei diesen Preisen dürfte die Wahl eigentlich nicht so schwer fallen. Die Empfehlung schlechthin lautet für mich zur Zeit 4870 für unter 100,-.

Liegt mit der deutlich teureren 5770 gleichauf und hängt die 5750 doch deutlich ab.

Für die neue Serie spricht vorerst nur der Stromverbrauch, DX11, die leicht verbesserte Bildqualität und die übrigen Zusatzfeatures.

P/L-technisch bleibt die 4870 ungeschlagen.

-- Veröffentlicht durch kammerjaeger am 1:29 am 25. Okt. 2009

Ja, auch die entsprechen den Specs.

Aktuell ist es eher bei Nvidia üblich, abgespeckte Karten zu vermarkten. So gibt es z.B. 9600GT mit DDR2 statt DDR3 und/oder 128bit statt 256bit...

Problem bei Herstellern wie Force3D ist eher, dass es problematisch wird, wenn die Karte mal in RMA muss und dann evtl. kein Deutschland-Importeur sich dafür verantwortlich sieht, weil es keinen mehr gibt. ;)

-- Veröffentlicht durch k3im am 0:45 am 25. Okt. 2009

Im November soll ja wohl angeblich schon die 5950 oder wie das X2 Model heissen soll rauskommen. Ich finds langsam echt frech das es null Karten und wenn, dann nur zu horrenden Preisen gibt. Für den X2 release ist das single GPU Angebot echt mager.

Oder bei ebay von Force3D. Was ist davon eigentlich zu halten? Ich sag mal so: es geht auch seriöser aber alles in allem... man würde ja wohl eine vollwertige 5870 bekommen oder was?

-- Veröffentlicht durch kammerjaeger am 15:48 am 24. Okt. 2009

Ich drück die Daumen, aber erwarte nicht zu viel...

-- Veröffentlicht durch Henro am 10:12 am 24. Okt. 2009

hmm ... wird sich zeigen. Ich hab jedenfalls am 16.10. eine bestellt (laut Shop lieferbar) und per Paypal bezahlt und nach telefonischer Rücksprache soll die am 27. wieder im Shop eintreffen.

-- Veröffentlicht durch kammerjaeger am 18:53 am 23. Okt. 2009

Wobei der Preis für die 5870 inkl. Dirt2 eher unter dem normalen Marktniveau liegen dürfte!

Die 5770 geht bei uns aber inzwischen auch für 149,- raus.

Für 130,- kann sie aktuell niemand einkaufen, ich bezweifle daher noch, dass sie am 27. auch wirklich kommt...

-- Veröffentlicht durch cheech2711 am 16:51 am 23. Okt. 2009

tjo, dass Gesetz des Marktes, hohe Nachfrage wenig Anbieter oder schlechte Verfügbarkeit, der der die Karten hat verkauft Sie teurer, würde ich auch machen:thumb:

-- Veröffentlicht durch Henro am 16:35 am 23. Okt. 2009

na da hab ich ja mit meiner vorbestellung der 5770er für 130 euro die schon bezahlt ist und für den 27.10. geliefert werden soll noch echt glück.

-- Veröffentlicht durch kammerjaeger am 23:10 am 22. Okt. 2009

Die 5870 inkl. Dirt2 gehen aktuell für 345,- weg, die 5850 für 235,- bzw. 255,- inkl. ExpressHD 150-Kabel. Die 5770 gibt es für 155,- und da sieht es mit der Verfügbarkeit noch ganz gut aus...

-- Veröffentlicht durch cheech2711 am 15:44 am 22. Okt. 2009

zu was für Preisen verkauft Ihr denn die 5850 und die 5770?

-- Veröffentlicht durch kammerjaeger am 14:04 am 22. Okt. 2009

Ich bekomme morgen 5870, 5850 und 5770 rein, die großen Karten sind aber schon alle vorbestellt...

Die Stückzahlen sind noch arg begrenzt, aber div. Hersteller liefern diese Woche aus.

-- Veröffentlicht durch cheech2711 am 13:14 am 22. Okt. 2009

Tja Nvidia hat nichts neues, jedenfalls nichts handfestes.

ATI hat was neues, aber auch nur in geringen Stückkzahlen, mehr Papiertiger als greifbare Hardware:blubb:

Auch wenn KJ jetzt wieder das Argument bringen wird, "ich bekomme ab und zu welche rein" ;-)

ATI vs Nvidia kämpfen jedes Jahr wieder mit gleichen Mittel um die virtuelle Schwanzverlängerung um die Konkurrenz schlecht aussehen zu lassen:ocinside:

-- Veröffentlicht durch k3im am 12:33 am 22. Okt. 2009

Tja, 22er und immer noch keine Grakas in Sicht. Echt bitter.

Ne 5850 für 259 €uro, nein danke.

Was geht denn da nur vor bei ATI?

-- Veröffentlicht durch kammerjaeger am 23:40 am 21. Okt. 2009

P.S.: Heute gerade vom Haupt-Importeur mehrerer Grafikkarten-Hersteller die Nachricht erhalten, dass sowohl GTX275/285/295 als auch 9600/9800 komplett abgekündigt sind! Lediglich die GTX260 sei momentan noch verfügbar, aber keiner weiß, wie lange das der Fall ist!

-- Veröffentlicht durch cheech2711 am 8:19 am 21. Okt. 2009

habe mir jetzt mal die 5770 etwas genauer angesehen, Benches ect..und muss sagen, dass es eine echt gute Karte zu einem genialen Preis ist:thumb: Gleichauf oder ein wenig hinter der Performance der 4870, dafür aber Shader 5.0 und DX11 und teilweise sogar knapp vor der HD4870.

PL ist mal wieder seitens ATI unschlagbar und das im Mittelklassesegment, allerdings ist die Verfügbarkeit der neuen Karten nach wie vor ein Graus.

5770 mein Tipp für den Low-Budged Gaming-PC :thumb:

-- Veröffentlicht durch kammerjaeger am 23:42 am 20. Okt. 2009

Man sollte auch nicht vergessen, dass die GTX295 teurer ist, 50W idle und 100W unter Last mehr zieht und kein DX11 kann.

Selbst eine 5850 X2 oder ein 5850 CF wird unter Last nicht mehr ziehen als die GTX295, sie aber leistungmäßig einstampfen bei etwa gleichem Preis... ;)

-- Veröffentlicht durch rage82 am 20:56 am 20. Okt. 2009

eine 4870x2 hat beinahe die gleiche rechenleistung (gleiche anzahl shader bei niedrigerem takt), aber dafür hat jede chip für sich sein speicherinterface, daher denke ich, das nicht nur die 5770 speichermehrtakt in leistung umsetzt, sondern die 5870 ganz genauso.

@henro bei den bios-editoren war die vram spannung meist aber auch nicht zu ändern. dafür musste man meines wissens fast immer mit nem lötkolben ran.

-- Veröffentlicht durch AssassinWarlord am 20:04 am 20. Okt. 2009

die haben ja aber auch eine Doppelte GPU, also nahezu doppelte leistung... so groß wird der sprung denke ich mal nie sein, das der nextGen Single Chip so stark ist wie das vorherrige Model als Dualgespann :noidea:

-- Veröffentlicht durch Steffen545 am 19:01 am 20. Okt. 2009

naja, laut den benches da oben ist die 5870 nicht sooooooo der überflieger. Da ist meistens die GTX295 oder die 4870 x2 schneller:noidea:

-- Veröffentlicht durch Henro am 18:53 am 20. Okt. 2009

Ist eigentlich schon irgendwas in richtung Bios Editor bekannt ? Mich würde ja die Spannungserhöhung beim RAM bei der 5770 interessieren denn diese habe ich mir am Wochenende bestellt ... die setzt ja durch die 128bit limitierung jedes % mehr bandbreite in Leistung um.

-- Veröffentlicht durch kammerjaeger am 23:09 am 16. Okt. 2009

Aber das Ansaugprinzip ist das gleiche...

-- Veröffentlicht durch rage82 am 19:51 am 16. Okt. 2009

die 5870 macht das aber nicht, die gtx260 sieht an dieser stelle sehr ähnlich aus und macht es auch nicht, bei der 5770 ist der kühlkörper kürzer und ragt nicht bis vor zur slotblende.

-- Veröffentlicht durch Henro am 17:29 am 16. Okt. 2009

und zur seite wenn man sich den kanalverlauf und die abzweigung am ende mal anschaut ...

-- Veröffentlicht durch kammerjaeger am 23:33 am 15. Okt. 2009

Beim Lüfter der 5770 sieht man das Prinzip sehr schön, es kann also nur nach vorne raus: klick

-- Veröffentlicht durch AssassinWarlord am 22:27 am 15. Okt. 2009

ahja :lol:

dann ist ja gut ^^

naja, die 5870 wird bei mir doch erstmal etwas warten müssen. hab erstmal eine 4870 wieder geordert, die sind ja recht günstig, und denke das reicht auch für mich, dafür das ich eh nur in ner 1280x1024er auflösung ohne AA und so nen schnickschnack spiele :lol:

-- Veröffentlicht durch rage82 am 22:25 am 15. Okt. 2009

jo, so hab ich das gemeint :lol:

-- Veröffentlicht durch AssassinWarlord am 22:16 am 15. Okt. 2009

:noidea::noidea:

der Radiallfter kann doch nicht nur oben ansaugen, sondrn auch unten - wo ja eigentlich das Graka PCB ist...aber zwischne PCB und Lüfter sind ein paar mm luft, sodas der Lüfter auch zwischen Kühlerkonstruckt und graka PCB luft ansaugen kann. die luft wird ringsrum um den radiallüfter abgestoßen und halt über das ganze lüftergehäuse seitlich abgefangen und da nach hinten geleitet

-- Veröffentlicht durch rage82 am 22:04 am 15. Okt. 2009

das würde dann bedeuten, die luft, die nach hinten weggeht wird dort im gehäuse aufgefangen und umgeleitet, sodaß die hinteren beiden eingänge die luft ansaugen, und der lüfter gar keine direkte öffnung zu diesen hat. das macht natürlich sinn :)

-- Veröffentlicht durch AssassinWarlord am 21:52 am 15. Okt. 2009

Jeder?

die haben die karte wohl getestet und es ebenfals so festgestellt wie ichs gesagt habe ^^ wozu sonst sollten sonst die öffnungen am ende der karte sein?

so ein Radiallüfter kann von beiden seiten Ansaugen wenns die bauform so hergibt. luft wird durch die rotationsbewegung nach außen hin beschleunigt, wie eine zentrifuge...durch den langn luftweg arbeiten die radialgebläse halt etwas ruiger als die Axial lüfter...

(Geändert von AssassinWarlord um 21:53 am Okt. 15, 2009)

-- Veröffentlicht durch rage82 am 21:40 am 15. Okt. 2009

also von unten macht schon sinn, das hab ich mir auch gedacht, aber da sich das ding im kreis dreht und in alle richtungen luft pustet, wird der effekt nach hinten wohl wesentlich stärker sein, als das ansaugen von unten.

aber wie gesagt, es schreibt jeder tester, das die karte darüber luft ansaugt, daher hätte ich gerne mal ne hands-on meinung :lol:

-- Veröffentlicht durch AssassinWarlord am 21:13 am 15. Okt. 2009

naja, wenn so ein radialgebläse andrs gebogen lüfterfinnen hat, funktioniert das ding genau andersrum...aber weitaus ineffizienter soviel ich weis.

ich glaube nicht, das die Karte hinten luft ansaugt

*confused*

soviel ich weis saugt die Graka aber noch an den zwei öffnungen am ende der karte auch noch luft an...das Radialgebläse kann ja auch unten luft ansaugen, nicht nur oben wo man direkt den lüfter sieht. Da wird halt von unten ebenfals luft angesaugt, durch die Spannungswandler druch. also am ende der Karte..

so kenne ich das von der

(Geändert von AssassinWarlord um 21:17 am Okt. 15, 2009)

-- Veröffentlicht durch rage82 am 20:56 am 15. Okt. 2009

hat hier jemand den kühler der hd5000er serie mal in aktion erlebt?

überall wird geschrieben, das die hinteren öffnungen zum ansaugen von kühler luft ist.

wie soll das bei nem radiallüfter funktionieren? der saugt doch von oben an und bläst sie dann rundherum raus, also müsste aus diesen öffnungen luft herauskommen (und damit das dhe-prinzip ein klein wenig über den haufen werfen).

würde mich mal interessieren.

-- Veröffentlicht durch rage82 am 0:47 am 14. Okt. 2009

dx11 hat tesselation. damit bringt man eine radeon 9870 zu fall wenn man nur will.

avp3 wurde damit schonmal vorgeführt. da fielen die fps von 600 auf 100. im wireframe konnte man erkennen warum. texturiert im spiel ist das wieder was ganz anderes.

dx10 ist genauso entwickelt worden, alles was dx9 kann, kann dx10 schneller. man benche xp gegen vista, vista unter dx10. da wird man nur noch analphabeten finden, die behaupten xp sei schneller ;)

-- Veröffentlicht durch kammerjaeger am 0:25 am 14. Okt. 2009

Zitat von cheech2711 um 14:22 am Okt. 13, 2009 wie Neuentwicklungen GT220 hinterm Zeitplan, bei Zack heute für 59 Euro zu haben und bei GHZ sind se auch gelistet. |

... und angekündigt waren sie für Frühjahr 2009... ;)

Zitat von spraadhans um 14:05 am Okt. 13, 2009 Abwarten, wer du die TReibertests bei CB verfolgt, weiß, dass große Sprünge in dem Bereich kaum noch gemacht werden. |

Leider falsch. Die Vergangenheit hat gezeigt, dass neue ATI-Generationen frühestens mit den übernächsten Treibern komplett rund laufen. So zeigt sich auch an den Bildfehlern bei Anno 1404 mit aktuellen Treibern und 5xxx-Karten, dass die Treiber eigentlich noch keinen Final-Status haben können. Erst ab dem dritten oder vierten Treiber einer neuen ATI-Karte sind kleinere Bugs in allen Spielen behoben und keine spürbaren Performance-Zuwächse mehr zu erwarten.

Der Sprung z.B. vom Cat. 7.7 zum 7.8 war gewaltig (klick). Zwischen 8.6 und 8.11 liegen "nur" ca. 5-6%, aber der 8.12 brachte in vielen Spielen auch wieder einen Sprung nach vorn (

klick). Die 9.x-Reihe brachte dann mit AA/AF nochmal 6-8% ggü. dem 8.12 (klick).

Danach tat sich dann nicht mehr viel, erst die 10.xx dürften wieder die nächste Evolutionsstufe sein und besonders den neuen Karten einen Schubs geben.

Zitat von spraadhans um 14:05 am Okt. 13, 2009 Ähnliches mit DX11, neue Effekte werden auch Rechenleistung binden, so dass DX11 vermutlich wieder im Vergleich langsamer als DX10 sein wird (natürlich bei besserer Optik). |

Hier belegen ebenfalls die Tests von Battleforge das Gegenteil! DX11 wurde entwickelt, um die Fähigkeiten aktueller Karten besser zu nutzen und bestimmte Effekte nur anders zu berechnen, was wirklich zu funktionieren scheint. Im Gegensatz dazu hat man bei DX10 neue Effekte hinzu gefügt, die zusätzliche Rechenleistung erforderten. ;)

-- Veröffentlicht durch spraadhans am 16:47 am 13. Okt. 2009

Und jede Wette, dass das angekündigte Call of Prypjat wieder nicht vernünftig auf den Mittelklassekarten läuft.

Der Vorgänger dürfte erst jetzt in 1080p ab einer 5850 mit hohen Details vernünftig laufen...

-- Veröffentlicht durch rage82 am 16:41 am 13. Okt. 2009

immerhin ist dx11 marketingtechnisch besser ins rennen geschickt worden. es gibt vergleiche zwischen dx10 und dx11, bei gleicher optik schneller.

sowas gab es zwischen dx9 und dx10 nicht, da wurden alle spiele langsamer und die optik nur punktuell besser (meist kaum sichtbar aber rechenintensiv)

man muss wohl warten wie schnell dx11 titel verfügbar werden, aber insgesamt, vor allem wohl auch wegen win7, ist die breite akzeptanz wesentlich höher und das sollte der hd5000 serie zugute kommen und wirklich absatzerhöhungen bringen.

-- Veröffentlicht durch cheech2711 am 14:22 am 13. Okt. 2009

wie Neuentwicklungen GT220 hinterm Zeitplan, bei Zack heute für 59 Euro zu haben und bei GHZ sind se auch gelistet.

Ich finde die Verfügbarkeit der 5850 echt schlecht, auch wenn Nvidia noch gar nichts am Start hat ausser der Vorstellung:-)

-- Veröffentlicht durch spraadhans am 14:05 am 13. Okt. 2009

Abwarten, wer du die TReibertests bei CB verfolgt, weiß, dass große Sprünge in dem Bereich kaum noch gemacht werden.

Ähnliches mit DX11, neue Effekte werden auch Rechenleistung binden, so dass DX11 vermutlich wieder im Vergleich langsamer als DX10 sein wird (natürlich bei besserer Optik).

-- Veröffentlicht durch kammerjaeger am 13:35 am 13. Okt. 2009

Zitat von rage82 um 8:44 am Okt. 13, 2009 es sieht eher so aus, als wäre die 5770 auf 4870 niveau, mal drunter mal drüber. |

Mit aktuellen Treibern und DX9/10 ist sie das auch. Aber u.U. kommt da noch (wie bei ATI bisher üblich) mit neueren Treibern ein kleiner Sprung und unter DX11 werden sie auch 25-30% zulegen, wie die ersten DX11-Benches belegen. Denn anders als DX10 vs. DX11 bringt DX11 tatsächlich Performance!

Insofern würde ich die 5770 eher leicht über der 4870 ansiedeln, auch wenn der Vorteil erst bei DX11 völlig zum Tragen kommt.

-- Veröffentlicht durch kammerjaeger am 13:31 am 13. Okt. 2009

Doch, ich hatte schon welche und bekomme diese Woche wieder Nachschub!

Und wieso Tohuwabu? Im Gegensatz zu Nvidia wird nicht großspurig etwas angekündigt und der Launchtermin momentan sogar eher vorverlegt, während Nvidia ja sogar einen Hype um umgelabelte oder nur minimal veränderte Karten macht (z.B. 9800GT oder GTS250) und dann bei Neuentwicklungen mal locker 4-6 Monate hinter dem Zeitplan steckt (z.B. GT220)... ;)

-- Veröffentlicht durch cheech2711 am 11:30 am 13. Okt. 2009

mit ATI isses auch immer wieder das Gleiche, riesen Towewabu und Lieferbarkeit = 0, von den 5870 waren ja schon mal ein paar in den Läden, aber die wirklich interessanten Karten, die gegenüber der 4870 einen wirklichen Boost, sprich Perfomancevorteil bringen und preislich erschwinglich sind, die sind zum verrecken net zu bekommen, immer die gleiche Info bei den Shops, Liefertermin unbekannt:eek:

Also noch hat ATI erst mal nur auf dem Papier die Nase vorn, zum Thema Nvidia dürfen wir sicherlich gespannt sein, wie es dort weitergehen wird.

-- Veröffentlicht durch rage82 am 8:44 am 13. Okt. 2009

Zitat von kammerjaeger um 23:34 am Okt. 12, 2009 Btw.: Morgen kommt bei mir die erste 5770 an, die 5750 folgt in ein paar Tagen. Marktpreis wird wohl zunächst bei knapp 150,- beginnen, das kleinere Modell bei gut 100,-. Bedenkt man, dass man mit der 5750 eine DX11-Karte bekommt, die in der Leistung nur knapp unter der 4870 liegt aber in der TDP die sparsame 4770 noch unterbietet, so wird das die ideale Mittelklasse-Gamer-Karte, die für viele User eine Aufrüstung ohne neues NT ermöglicht. |

es sieht eher so aus, als wäre die 5770 auf 4870 niveau, mal drunter mal drüber.

-- Veröffentlicht durch spraadhans am 8:40 am 13. Okt. 2009

In 4 Jahren wird bei AMD aber durch einen fertigungsbedingten Großserienfehler eine ganze Grafikkartenserie zurückgerufen. Das wird die Kanadier um 1 Jahr zurückwerfen.

Nvidia wird sich auf mobile Endgeräte konzentrieren und durch deren Boom in ca. 3 Jahren Gewinne auf dem Niveau von 2007 einfahren.

Schwarz-Gelb wird 2013 wiedergewählt, im Jahre 2080 haben wir den Weltfrieden erreicht...

Meine Glaskugel ist länger als eure...().

-- Veröffentlicht durch kammerjaeger am 23:34 am 12. Okt. 2009

Btw.: Morgen kommt bei mir die erste 5770 an, die 5750 folgt in ein paar Tagen.

Marktpreis wird wohl zunächst bei knapp 150,- beginnen, das kleinere Modell bei gut 100,-.

Bedenkt man, dass man mit der 5750 eine DX11-Karte bekommt, die in der Leistung nur knapp unter der 4870 liegt aber in der TDP die sparsame 4770 noch unterbietet, so wird das die ideale Mittelklasse-Gamer-Karte, die für viele User eine Aufrüstung ohne neues NT ermöglicht.

-- Veröffentlicht durch kammerjaeger am 23:26 am 12. Okt. 2009

Nein, ich denke eher, dass es sich ähnlich wie PC und MAC in zwei eigenständige Plattformen mit unterschiedlichen Zielgruppen entwickeln könnte. Die Software kann jedoch auf beiden Plattformen laufen, so wie ja inzwischen auch Windows auf dem MAC funzt.

Einen Krieg zwischen AMD- und Intel- bzw. Nvidia- und ATI-Anhängern wird es dann genauso wenig geben wie man nur schwer Server-Hardware und Desktop-Systeme vergleichen kann (z.B. Xeon und NV Quadro vs. Phenom II und Radeon 58xx). ;)

-- Veröffentlicht durch cheech2711 am 14:46 am 12. Okt. 2009

Zitat von Hitman um 9:50 am Okt. 12, 2009 Also nach dem Aufkauf von Nvidia durch Intel wärs ja dann wieder: Intel vs. AMD. Dann gehts hier im Forum wieder rund. :yucky: |

zBsp: hey ATI ist besser als Nvidia---Niemals :rocket: doch ---Nein:killer:

Nvidia hat das besser Produkt---Niemals :rocket::punch::fu:

so oder doch lieber so:kick: oder lieber :poor: Nvidiabesitzer

-- Veröffentlicht durch AssassinWarlord am 14:08 am 12. Okt. 2009

sli wird es sicherlich auch nimmer lange geben kann ich mir vorstellen. es ist verschwenderrisch, zwei oder mehr externe Cores zu betreiben, ist sozusagen die billigste variante, mehr leistung rauszuholen. Dan lieber direkt Dual oder Quad GPU Cores bauen, wo mehrere Prozessoreinheiten unter einer Haube sind, die extern gesehen sich nichts teilen müssen.

wie ist das momentan mit den GX2 karten? braucht man da echt ein SLI fähiges Board was min zwei PCIe x16 slots hat, obwohl man nur eine Karte hat die ledeglich einen PCIe x16 slot belegt? oO währe dann auch etwas sinnlos in meinen augen so eine karte wenn sie nichtmal eigenständig arbeiten kann :lol:

Wie ist das bei AMD mit der X² ? wird da ein crossfireboard benötigt? da kann ichs mir wiederrum nicht vorstellen das man eins braucht, da AMD selbst diese technologie erfunden hat, damals schon mit der Rage Furry Maxx - die hat auch nur einen AGP Slot belegt, trotz zwei GPUs. und die Karte war nicht schlecht :godlike:

(Geändert von AssassinWarlord um 14:09 am Okt. 12, 2009)

-- Veröffentlicht durch rage82 am 12:38 am 12. Okt. 2009

Zitat von kammerjaeger um 0:34 am Okt. 12, 2009 Es sieht also so aus, als würde SLI sterben (denn ohne passende Chipsätze und GTX-Karten macht es wohl wenig Sinn...) und damit auch all das, wofür Nvidia sich in Unkosten gestürzt hat, wie z.B. PhysX. Wenn Nvidia nicht plötzlich zusammen mit dem GT300 noch ein weiteres Ei aus dem Hut zaubert und dies möglichst schnell, dann sehe ich da wenig Licht am Ende des Tunnels! Man muss kein Hellseher sein, um sich solche Szenarien vorstellen zu können: Da Nvidia sich auf andere Bereiche verlegt oder Pleite ist, kauft Intel von Nvidia die SLI-Technologie und PhysX sowie die Rechte am GT300 und dessen Weiterentwicklung sowie die Nutzung von CUDA. So kann Intel ausgrenzen, dass der GT300 eine zu große Konkurrenz zu den eigenen CPUs wird. Da weder Intel noch AMD Chipsätze für den Konkurrenten baut, könnten sich also zwei komplett konkurrierende Plattformen entwickeln, nämlich PhysX auf Intel und Havok auf AMD. Intel hätte dann dank CUDA und PhysX zwar einen Vorteil in manchen Bereichen, muss aber den Zeitvorteil im GraKa-Sektor von AMD aufholen, was durch die Umstrukturierung im eigenen Haus nicht einfacher wird... |

hast du da nicht ein bischen zu einfach gedacht?

sli sterben? blos weil nv keine chipsätze mehr entwickelt? dagegen spricht doch die einfachste, günstigste variante geld zu verdienen: lizenzen, geld verdienen ohne dafür entwickeln zu müssen.

insgesamt propagierst du ja quasi den weltuntergang, der schon seit 4000jahren immer wieder verschoben wurde. hier wird nichts anderes passieren. amd hat 20% anteil im prozessorgeschäft und hatte technologievorteile auf seiner seite. amd lebt noch immer, sogar beinahe selbstständig. nv steht finanziell wesentlich besser da als amd und daher warten wir mal ab.

-- Veröffentlicht durch Hitman am 9:50 am 12. Okt. 2009

Also nach dem Aufkauf von Nvidia durch Intel wärs ja dann wieder:

Intel vs. AMD.

Dann gehts hier im Forum wieder rund. :yucky:

-- Veröffentlicht durch spraadhans am 8:40 am 12. Okt. 2009

Abwarten, AMD hat auch trotz jahrelanger Verluste eigentständig überlebt. Der Kurs sieht normal aus...

-- Veröffentlicht durch kammerjaeger am 8:30 am 12. Okt. 2009

Noch ist es nicht zu spät. Der Kurs ist zwar etwas vom Hoch Anfang September entfernt, aber die Verluste wären gering ggü. der bisherigen Entwicklung der letzten 12 Monate: klick

(Geändert von kammerjaeger um 8:33 am Okt. 12, 2009)

-- Veröffentlicht durch cheech2711 am 8:14 am 12. Okt. 2009

Zitat von kammerjaeger um 0:34 am Okt. 12, 2009 Btw.: Wer noch Nvidia-Aktien hat, sollte diese u.U. so schnell wie möglich verkaufen!!! |

zu spät:lol: jetzt würdest Du wohl nichts mehr bekommen, oder nur Verlust einfahren.

Besser behalten und bei guten News wie Fusion Intel-Nvidia, wenn se wieder klettern, abstoßen:thumb:

-- Veröffentlicht durch kammerjaeger am 0:34 am 12. Okt. 2009

Wow, so langsam wird es eng für Nvidia!

Nachdem man sich ja aufgrund von Erfolglosigkeit bzw. starken Rückgängen im Server-Segment von einer Chipproduktion für diese Sparte schon zurückgezogen hatte (Nforce 3600 abgekündigt, kein Nachfolger geplant) und auch für Intels Sockeln 1366 und 1156 keine Chips produziert, hat man nun auch die Abkehr von Chipsätzen für AMDs Desktop-Sparte angekündigt!

Bedenkt man dann noch die Ansage, die gesamte GTX-Reihe auslaufen zu lassen, bleibt außer einigen Notebook-Chips und dem ITX-Markt (Geforce 9300/9400) nicht mehr viel übrig!

Da kann dann auch der gerade erschienene GT220 nicht mehr viel helfen, welcher nur ein leicht überarbeiteter G9x ist, dem man DX10.1 spendiert hat und der leistungsmäßig zwischen 9500GT und 9600GT liegt, beim Preis aber auf dem Niveau der 9600GT (Straßenpreis 512MB ab ca. €60,- und 1024MB ab ca. €70,-).

In den nächsten Tagen soll die Mittelklasse von ATI kommen, welche nach aktuellen Meldungen preislich wesentlich attraktiver wird als man noch vor 1-2 Wochen dachte!

So soll die 5750 bei $109,- (512MB) bzw. $129,- (1024MB) und die 5770 bei $149-159,- (1024MB) landen! Bedenkt man dann die ersten Benchmarks, bei denen die 5750 nur knapp hinter der 4870 landet und die 5770 nur knapp hinter der 4890, dann sind es echte Kampfpreise, zumal die TDP sehr gering ist (5750 -> 86W und idle 16W, 5770 -> 108W und idle 18W).

Damit sieht es dann auch für die Mittelklasse von Nvidia trübe aus (GTS250, 9800GT), zumal kein Nachfolger in Sicht ist.

Weiterhin ist damit zu rechnen, dass ATI auch in Kürze die Low-Budget-Karten bringen wird (55xx + 53xx), wo also soll Nvidia da noch Platz für konkurrenzfähige Karten haben, wenn Windows7 da ist, aber Nvidia auch in naher Zukunft keinerlei DX11-Konkurrenz oder preislich attraktive Karten im Programm hat? :noidea:

Es sieht also so aus, als würde SLI sterben (denn ohne passende Chipsätze und GTX-Karten macht es wohl wenig Sinn...) und damit auch all das, wofür Nvidia sich in Unkosten gestürzt hat, wie z.B. PhysX.

Wenn Nvidia nicht plötzlich zusammen mit dem GT300 noch ein weiteres Ei aus dem Hut zaubert und dies möglichst schnell, dann sehe ich da wenig Licht am Ende des Tunnels! Man muss kein Hellseher sein, um sich solche Szenarien vorstellen zu können:

Da Nvidia sich auf andere Bereiche verlegt oder Pleite ist, kauft Intel von Nvidia die SLI-Technologie und PhysX sowie die Rechte am GT300 und dessen Weiterentwicklung sowie die Nutzung von CUDA. So kann Intel ausgrenzen, dass der GT300 eine zu große Konkurrenz zu den eigenen CPUs wird. Da weder Intel noch AMD Chipsätze für den Konkurrenten baut, könnten sich also zwei komplett konkurrierende Plattformen entwickeln, nämlich PhysX auf Intel und Havok auf AMD. Intel hätte dann dank CUDA und PhysX zwar einen Vorteil in manchen Bereichen, muss aber den Zeitvorteil im GraKa-Sektor von AMD aufholen, was durch die Umstrukturierung im eigenen Haus nicht einfacher wird...

So könnte es tatsächlich ein technologisches Wettrennen zweier Plattformen geben, die sich völlig autark entwickeln.

Btw.: Wer noch Nvidia-Aktien hat, sollte diese u.U. so schnell wie möglich verkaufen!!!

-- Veröffentlicht durch Xpect am 23:07 am 11. Okt. 2009

Das ist klar, aber FullHD auf nem 22" sind schon ne hohe Pixeldichte afaik.

Schlimmer ist das einige Spiele wie z.B. Prototype nciht auf max. laufen wollen, auch ohne AA (an kein-AA hab ich mcih schon gewöhnt)

-- Veröffentlicht durch spraadhans am 20:54 am 11. Okt. 2009

Wobei ich in der auflösung zum Glück kaum AA brauch |

Ein weit verbreiteter Irrglaube, nur die dpi Zahlen sind entscheidend...

-- Veröffentlicht durch Xpect am 19:34 am 11. Okt. 2009

Ich dachte ich hätts schon geposted.

Was für ein Bildflackern? dieses minimale Flackern beim Wechseln des Taktes? Was ist daran so schlimm? Mich störts ehrlich gesagt nicht, gut wenn ich ein Spiel starte dauerts 5 sek bis das Spiel starten kann wegen dem Flackern auf Monitor 2, aber wayne?

-- Veröffentlicht durch rage82 am 12:07 am 10. Okt. 2009

ht4u haben ihre 5870 und eine 2te ein weiteres mal untersucht und dabei für mich überaus interessante sachen gemesssen. der link zeigt direkt zum test der leistungsaufnahme bei dual-monitor betrieb.

da wird die taktrate nicht mehr auf 157mhz sondern 400 gesenkt und der ddr5 speicher gar nicht abgesenkt, da sich ansonsten wieder das bildflackern einstellen würde/könnte.

die gpu-spannung wird wegen des höheren taktes auch nicht mehr soweit abgesenkt (bei nv ist es das gleiche spiel).

ich merke allerdings keine probleme bei meiner 4870, bei taktraten von 200/300 und 0,94v gpu-spannung.

also muss ich dann wohl wieder auf software zurückgreifen um befriedigende ergebnisse zu erhalten. ich wusste nicht, das ich ein worst-case szenario liebhaber bin :lol:

edit:

und hier was zu unserem streit wegen der leistungsaufnahme. beinahe 10w unterschied zwischen 5870 und 5870 bei bioshock

(Geändert von rage82 um 12:11 am Okt. 10, 2009)

-- Veröffentlicht durch Xpect am 14:58 am 1. Okt. 2009

Jep hab ich auch festgestellt, in meiner Auflösung (1080p) hat meine 512MB Auch in einigen spielen zu kämpfen auf max. AA. Wobei ich in der auflösung zum Glück kaum AA brauch ;)

-- Veröffentlicht durch rage82 am 7:59 am 1. Okt. 2009

@spraadhans

die 512mb-version hat bei 4xaa und 16af mitunter zu kämpfen.

daher ist die 5850 auf dem wunschzettel, allerdings erst ende des jahres, wenn der gestern vorgestellte gt300 dann die preise drückt.

@lucifer also wenn sich das nette bildchen im cb-test nicht selbst verrechet sind es zur 4870/1gb 38% bei 4xaa

-- Veröffentlicht durch Lucifer am 7:40 am 1. Okt. 2009

Also bei CB ist durchgängig bei jeder Auflösung eigentlich im schnitt 40% schneller. Also ist das Midrage Modell der neuen Reihe 40% schneller als das topmodel von damals. Vergleicht man beide xx70 sind es 60%

Und verglichen zu deiner 8800GT bzw der 9800GT/GTS250 im Test ist selbst eine 4870 30 - 40% schneller...

Und die 5870 ist 200-250% schneller als deine karte

(Geändert von Lucifer um 7:41 am Okt. 1, 2009)

-- Veröffentlicht durch spraadhans am 7:26 am 1. Okt. 2009

Erstmal die Preissenkungen abwarten, wenn eine 5850 um die 200,- kosten soll, bietet eine unter die 100,- Grenze gefallen 4870 512 MB erheblich mehr fürs Geld. Und NV wird mit der GTX260 nachziehen müssen.

@rage:

für 33% Mehrleistung eine neue Karte kaufen ist dekadent :biglol:, ich zocke immer noch mit meiner 8800GT, weil es selbst in 1080p fast nichts gibt, was nicht ordentlich läuft (GTA; Batman, CoJ2) und ein Neukauf m.E. erst lohnt, wenn wenigstens 50% mehr drin sind.

-- Veröffentlicht durch TheOne am 22:44 am 30. Sep. 2009

Jop die Karte klingt am vielversprechendsten, aber auch die HD5870 ist ein tolles Stück Hardware geworden. Bin mit dem Gesamtergebnis vonAMD zufrieden und warte nun gespannt auf nVidias Fermi :)

-- Veröffentlicht durch rage82 am 20:41 am 30. Sep. 2009

5850(cf) test bei computerbase

in meiner wunschauflösung 33% mehrleistung als eine 4870/1gb, meine hat nur 512mb. verbrauchswerte wie es mir gewünscht habe.

ich glaube auch, das dies meine karte wird, zumal die lautstärke messungen hier wesentlich besser ausgefallen sind (auch relativ ;) ) als bei pcgh.

-- Veröffentlicht durch Ino am 20:19 am 30. Sep. 2009

Die 5850 scheint für mich echt interessant zu sein.

werde mal am ende des jahres gucken was das teil kostet.

meine g7900 GTO muss mal langsam abgelöst werden

-- Veröffentlicht durch rage82 am 8:05 am 30. Sep. 2009

5850 bei pcgh

angeblich sogar gesenkte chip-spannung, nur unter last etwas laut

-- Veröffentlicht durch kammerjaeger am 8:43 am 29. Sep. 2009

Zitat von smoke81 um 21:18 am Sep. 23, 2009 Zudem misst THG mit Furmark, für die Spiele-Realität recht uninteressant... |

Vielleicht für den realen Verbrauch, aber nicht für den max. Stromverbrauch, was z.B. für die Netzteilbelastung wichtig ist.

Wenn Du Dir die Spitzenströme bei ht4u anschaust, dann sieht man, dass die GTX285 z.B. bei Bioshock zwar durchschnittlich "nur" 13,9A zieht, nach etwas Spielzeit aber konstant >14,2A liegt und Spitzenströme von gut 16,7A verursacht, also eine Differenz von immerhin 34W zum Durchschnitt!

-- Veröffentlicht durch kammerjaeger am 8:17 am 29. Sep. 2009

Aus dem Link zu tweakpc, worauf Du geantwortet hattest!

Dort wird mit Furmark getestet, nicht wie bei CB mit Bioshock.

-- Veröffentlicht durch spraadhans am 7:34 am 29. Sep. 2009

Wo hast du die Werte her?

Auf CB beträgt der Unterschied 25-30w (was immer noch respektabel ist).

-- Veröffentlicht durch kammerjaeger am 23:42 am 28. Sep. 2009

Zitat von spraadhans um 9:25 am Sep. 28, 2009 In Anbetracht der gebotenen Leistung ist das doch wirklich ordentlich. |

Stimmt. 70W weniger als eine GTX275 und 66W weniger als die GTX285 unter Last sind schon eine Menge! :thumb:

-- Veröffentlicht durch rage82 am 12:10 am 28. Sep. 2009

das denke ich auch, das smoke das gemeint hat. da die 5850 wahrscheinlich aus defekten rv870xt-chips stammen wird, werden wir wohl keine verringerte core-spannung erwarten dürfen.

was mich allerdings bei techpowerup wundert:

"We simulated the performance of the HD 5850 by taking our HD 5870, reducing the clock speeds and disabling two SIMDs, which results in exactly the same performance as HD 5850."

soso, die haben also 2 simd-blöcke deaktiviert?

computerbase hat den takt soweit verringert, das bei MADD-schritten die gleiche theoretische rechenleistung herauskommt, was deren ergebnisse natürlich ungenau macht, aber näherungsweise richtig erscheinen lässt.

aber wie das techpowerup mal eben lapidar in einer zeile erwähnt, kommt mir schon komisch vor.

dann hätten sie auch noch lautstärke,temps und verbrauchswerte bringen können...

-- Veröffentlicht durch spraadhans am 11:54 am 28. Sep. 2009

Smoke hat vermutlich die Leistungsaufnahme und nicht die Leistung gemeint;).

-- Veröffentlicht durch KakYo am 11:17 am 28. Sep. 2009

Die 5850 liegt laut diesem Test zwischen GTX 285 und HD4870 X2

Also ein ganzes Stück über ner 4870 ;)

click

Allerdings wurde die Karte nur simuliert.

-- Veröffentlicht durch smoke81 am 10:58 am 28. Sep. 2009

Dann kann man nur vermuten, dass die HD5850 auf dem Niveau der HD4870 oder darunter liegt und die kommende HD5770,

oder wie sie heißen mag, wohl in etwa bei einer HD4850 oder darunter. :thumb:

Edit:

Gemeint ist der Stromverbrauch...

(Geändert von smoke81 um 17:05 am Sep. 28, 2009)

-- Veröffentlicht durch spraadhans am 9:25 am 28. Sep. 2009

In Anbetracht der gebotenen Leistung ist das doch wirklich ordentlich.

-- Veröffentlicht durch rage82 am 9:12 am 28. Sep. 2009

tweakpc haben sich eine powercolor auf dem freien markt ergattert und nochmal lautstärke, temps und verbrauch nachgemessen. auch hier liegen 4890 und 5870 gleichauf. leider gibts keine angaben wie der wert zustande kommt.

-- Veröffentlicht durch spraadhans am 18:50 am 27. Sep. 2009

Naja, die Asuskarten erkaufen das durch eine extrem gestiegene Spannung, das wird bei einer 5890 nicht anders werden. Interessant werden die Mittelklasseableger, wenn die Leistung auf 4870 Niveau und der Stromverbrauch deutlich gesenkt wurde...

(Geändert von spraadhans um 19:58 am Sep. 27, 2009)

-- Veröffentlicht durch Henro am 18:41 am 27. Sep. 2009

Zitat von rage82 um 14:47 am Sep. 26, 2009 das auf jedenfall, aber amd hat ja die 5870 nicht gegen die gtx285 positioniert, man will ja dem gt300 paroli bieten :) |

Ich habe heute gelesen das AMD gerüchten zufolge noch eine 5890 in der Hinterhand hat. Wenn man sich die Karten von Asus ansieht die ja direkt zum launch mit hohen übertaktungsergebnissen werben dann scheint das auch gar nicht so abwägig.

Ich denke aber das es so weiter gehen wird wie bisher : nVidia wird mit dem GT300 die schnellste DX11 Graka zum Ende des Jahres stellen, AMD wird aber nur wenig dahinter liegen und mit besseren Preisen punkten.

-- Veröffentlicht durch kammerjaeger am 15:11 am 26. Sep. 2009

Hat auch niemand etwas anderes behauptet! Aber die GTX285 ist nunmal jetzt schon uninteressant (selbst im Vergleich zur hauseigenen Konkurrenz) und wird es durch den Nachfolger umso mehr. Insofern wird man sie, unabhängig von den Produktionkosten, bald billig verkaufen müssen... ;)

-- Veröffentlicht durch rage82 am 14:47 am 26. Sep. 2009

das auf jedenfall, aber amd hat ja die 5870 nicht gegen die gtx285 positioniert, man will ja dem gt300 paroli bieten :)

-- Veröffentlicht durch kammerjaeger am 14:23 am 26. Sep. 2009

Zitat von rage82 um 13:40 am Sep. 26, 2009 amd wird den preis wahrscheinlich schon senken, wenn nv die gtx285 zum kampfpreis hergeben sollte. aber daran glaube ich aufgrund der hohen produktionskosten nicht wirklich. |

Müssen sie aber spätestens dann, wenn der Nachfolger da ist. Die GTX285 ist jetzt schon preis/leistungstechnisch uninteressant ggü. der kaum langsameren aber deutlich preiswerteren GTX275. Spätestens mit der Nachfolge-Generation wird die GTX285 also den Gnadenstoß bekommen...

-- Veröffentlicht durch rage82 am 13:40 am 26. Sep. 2009

sie werden zum erstenmal fallen, in 2-3 wochen, wenn die karten in allen shops erhältlich sind und jeder die karten an den mann bringen will.

zum 2ten mal, sobald nv den gt300 vorstellt, denn ich bin sicher das er die 5870 schlagen wird.

selbst wenn es anders kommt, das fände ich umso besser für amd, aber einmal werden die preise in nächster zukunft fallen.

amd wird den preis wahrscheinlich schon senken, wenn nv die gtx285 zum kampfpreis hergeben sollte. aber daran glaube ich aufgrund der hohen produktionskosten nicht wirklich.

-- Veröffentlicht durch k3im am 13:36 am 26. Sep. 2009

Und was für realistische Preise schweben dir da so vor? Und vor allen Dingen wann? Ausserdem sind die die an der Preis Schraube drehen müssen beim release der gelbe nvidia Verein.

Ich habe immo keinen brauchbaren 3D Beschleuniger. Da kommt es sich ganz gut aus das jetzt die neue Genereation rauskommt. Da bisher die Preise für neue Dicke Karten immer um die 500 angesiedelt waren finde ich 300 €uro für die schnellste Single Karte am Markt voll in Ordnung.

Im HW Bereich kann man Theroretisch den Leuten immer von einem Kauf abraten, weil die Sachen auch immer im Preis fallen irgendwann.

-- Veröffentlicht durch rage82 am 13:30 am 26. Sep. 2009

ich denke vor allem, das die 5850 wesentlich interessanter ist.

wenn man sich hier die news mit den übertakteten karten von asus anschaut, werden die 5850 und 70 den gleichen takt erhalten. der unterschied liegt also bei 32(vec5) shadern.

der unterschied beim vantage beträgt laut asus 3%. die unterschiede beim vantage lassen sich auf auf die meisten spiele übertragen. aber gut sagen wir mal 5% differenz.

mit gutem speicher gesegnet wird die 5850 also fast so schnell wie eine 5870, wo immer die speicherbandbreite gefragt ist. rechenleistung haben beide karten genug.

daher warte ich gespannt auf die 5850, die preis-leistungstechnisch wohl die bombe am markt wird, zumindest bis november ;)

-- Veröffentlicht durch spraadhans am 13:13 am 26. Sep. 2009

Wer jetzt zu den aktuellen Preisen vorbestellt ist ein seltener Schwachvogel, da die Vergangenheit gezeigt hat, dass die Preise vor Erscheinen eher zu hoch als zu niedrig kalkuliert waren.

Aber macht mal, freut mich für die Shops und ATI.

-- Veröffentlicht durch k3im am 13:06 am 26. Sep. 2009

Zitat von AssassinWarlord um 19:55 am Sep. 24, 2009 ...oaar ich werd immer schwächer *g* der Vorbestellen Knopf wird immer größer :lol: |

Genau das ist der Punkt. Auf jeden Fall will ich das Teil haben. Die Frage ist nur, wo vorbestellen? Alternate z.B. Listet das Teil mit 350 €uro. Da hat man zwar die Sicherheit das man nicht abgezockt wird aber de rPreis ist schon krass. Wo bestellt ihr vor? Oder gebt ihr das aus 10% Gründen nicht bekannt :lol:

-- Veröffentlicht durch AssassinWarlord am 19:55 am 24. Sep. 2009

die 5870 kostet auch "nur" noch 290€...eigentlich echt nicht schlecht für das, was das Kärtchen so an leistung schiebt...oaar ich werd immer schwächer *g* der Vorbestellen Knopf wird immer größer :lol:

-- Veröffentlicht durch smoke81 am 17:16 am 24. Sep. 2009

Die Preise der 5850er habe ich bereits gesehen, allerdings wird wohl zuerst die 5870 erscheinen und dies auch in eher niedrigen Stückzahlen. Angeblich hat Dell einen Riesenposten zugesichert bekommen und von der bisherigen Produktion sollen nur 10% für den Retail-Markt übrig sein, ungefähr der Anteil bisheriger Vorbestellungen...

Aber wir werden sehen, wie sich die weitere Produktion und Verfügbarkeit entwickeln wird. Ein Technikvorsprung nutzt ATI jedenfalls wenig, wenn die Ware nicht geliefert werden kann.

-- Veröffentlicht durch cheech2711 am 16:47 am 24. Sep. 2009

wenn man sich mal die Vergleiche zur GTX285 anschaut, die nur 40Euro günstiger zu haben ist, gibt es hier doch gar keine andere Wahl als ATI:thumb: der Unterschied ist beträchtlich und man kann davon ausgehen, dass Nvidia in der Referenz wesentlich teurer sein wird.

@smoke, gelistet sind die 5850 bei Geizhalz (Liefertermin 30.09.2009) schon und das für 203 Euro, mal sehen wo sich die Preise dann im Endeffekt einpendeln werden

-- Veröffentlicht durch smoke81 am 10:53 am 24. Sep. 2009

Theoretisch ja, aber die wenigsten von uns legen 300+ Öcken für eine Graka hin... und die 5850 lässt noch auf sich warten.

-- Veröffentlicht durch spraadhans am 8:33 am 24. Sep. 2009

Naja, ganz genau können wir die getesteten Werte hier ohnehin nicht nachvollziehen.

Fakt ist, dass die Karte sehr schnell ist bei verbesserter Qualität und angemessener Energieeffizienz.

Bis zum Erscheinen der GT300 Chips kann ATI also endlich mal ein wenig Geld verdienen...

-- Veröffentlicht durch rage82 am 8:16 am 24. Sep. 2009

hartware

auch hier braucht die 5870 ein klein wenig mehr als als die 4890.

und ob du es glaubst oder nicht, ich habe es natürlich gewagt meine 4870 unter furmark mit umbenannter exe zu testen. die karte wäre bei defekt jedesmal zurück gegangen, solange bis ich ein modell erhalten hätte das mir liefert was der hersteller verspricht.

edit:

ht4u testet wie pcgh nur den verbrauch der karte und erreicht unter bioshock 4w mehr als die 4890, unter furmark 4w weniger und 20w mehr als pcgh, wo hingegen der idle verbrauch gleich gemessen wurde.

(Geändert von rage82 um 8:22 am Sep. 24, 2009)

edit 2:

hier kann man z.b. nachlesen das nv-grakas wesentlich besser ausgelastet werden und der furmark "nur" 10% mehr als ein spiel benötigt ;)

vielleicht haben wir es einfach mit schwankungen der vorserienmodellen zu tun, leider sind nur bei einem review die spannungen der karte erwähnt und vermessen.

(Geändert von rage82 um 8:28 am Sep. 24, 2009)

(Geändert von rage82 um 8:30 am Sep. 24, 2009)

edit klappe die 3te:

schaut man durch mehrere englischsprachige

reviews so liegen die karten overall gleichauf, mit den gleichen schwankungen wie in deutschen reviews

(Geändert von rage82 um 9:01 am Sep. 24, 2009)

-- Veröffentlicht durch smoke81 am 8:05 am 24. Sep. 2009

Bei den Spielen meinte ich beispielsweise, dass hier nicht die kompliziertesten Shaderabfolgen etc. zum Tragen kommen, sobald das gleiche Bild durch einfachere (oder weniger) Shader vergleichbar dargestellt werden kann. Im Prinzip hat sich hier seit DX9 kaum etwas geändert.

Selbst CUDA wird keine Auslastung vergleichbar mit dem Furmark hervorrufen, schlichtweg, weil es etliche Einheiten gibt, die keine CUDA-Berechnungen durchführen bzw. dafür nicht geeignet sind, diese laufen im IDLE oder werden teilweise sogar komplett abgeschaltet und getrennt.

THG hat selber geschrieben, dass sie unter Win7 getestet haben und ein seltsames Verhalten gemessen haben beim Stromverbrauch, zudem wurde nur die Messung an der Steckdose gemacht, wie sie der Laie mit einem 5-Euro-Teil aus dem Baumarkt auch versucht nachzuvollziehen.

PCGH dagegen nimmt einen modernen Prüfstand, ein Vista, dessen Praxiseigenheiten bekannt sind und misst nur den Graka-eigenen Verbrauch.

Welche Messung ist nun als vertrauenswürdiger einzuschätzen?

Anders argumentiert:

Wenn Furmark zu berücksichtigen ist, dann starte das Programm mal nach Umbenennung der exe-Datei mit aktuellen ATI-Karten. Die Wahrscheinlichkeit, dass die Karte mit dieser Abschaltung der Treiberdrosselung abraucht, ist ganz gut. Wenn für Dich also Furmark state-of-the-art ist, dann sind alle ATI schlichtweg nicht für den Alltagsbetrieb geeignet. :lol:

-- Veröffentlicht durch rage82 am 23:33 am 23. Sep. 2009

cuda oder ähnliches?

da wird auch die gpu möglichst voll ausgelastet. wer furmark als realitätsfern bezeichnet scheint sich nicht in selbiger aufzuhalten, schliesslich erlebt er gerade den verbrauch ;)

natürlich sind es keine linearen zusammenhänge, schon eine kapazität vernichtet die linearität. noch einfacher ist der simple zusammenhang aus leistung,spannung und widerstand ;)

der effekt der strukturverkleinerung bringt nicht automatisch den vorteil eines geringeren verbrauchs, hat man erst vor wenigen jahren bei intel gesehen. die 5870 hat gegenüber den vorgängern eine niedrigere spannung bei mehr als doppelt so vielen transistoren. grob überschlagen sollte die karte also den gleichen verbrauch wie ein 4890 aufweisen. und je effektiver sie ausgelastet werden kann desto mehr transistoren arbeiten.

die aussage zu den spielen versteh ich ehrlich gesagt nicht. also ich verstehe was du meinst und stimme dir da zu. aber erklär mal der grafikkarte das sie ja weniger berechnungen nicht in mehr frames umsetzen soll wenn sie es kann ;)

-- Veröffentlicht durch smoke81 am 23:31 am 23. Sep. 2009

Mach mal der Übersichtlichkeit wegen einen neuen Beitrag...

PCGH schreibt misst sehr genau und schreibt folgendes:

Um Ihnen präzise Temperatur- und Leistungsaufnahme-Werte zu liefern, messen wir nicht den Verbrauch des Gesamtsystems, sondern ermitteln aufwendig nur den Konsum der Grafikkarte. Dabei kommen die Messstation Adexelec PEX16IX und das Zangenamperemeter Chauvin Arnoux F09 AC/DC zum Einsatz. Einerseits messen wir die 2D-Werte auf dem Vista-Desktop, andererseits auch die Last-Temperaturen. Hierbei setzen wir auf Race Driver: Grid in 1.920 x 1.200 mit 4x MSAA und 16:1 AF. Das Spiel fordert die Karten gleichmäßiger als Crysis Warhead und viele andere Spiele. Als absolutes Worst-Case-Szenario ziehen wir zudem den Ozone3D Furmark in der Version 1.6.5 heran. |

CB und THG messen nur das Gesamtsystem (THG sogar unter Win7), sodass hier noch ganz andere Einflüsse zum Tragen kommen.

Die Ergebnisse bei PCGH:

Furmark: HD5870 40W (!) weniger als HD4890

Grid: HD5870 30W (!) weniger als HD4890

Zum Selbernachlesen: klick

-- Veröffentlicht durch smoke81 am 23:16 am 23. Sep. 2009

Bei den einen verbraucht sie 20W mehr, bei den anderen 20W weniger... 40W Unterschied muss man schon hinterfragen.

Zu den 27% weniger... Denke dreidimensional, dann benötigt man theoretisch 62% weniger Platz für die gleiche Zahl Transistoren ;)

EDIT:

CB und THG sind die Ausnahme, die meisten Tests sagen bisher etwas anderes zur Leistungsaufnahme.

Ich zitiere mal Golem, da die Aussage auch recht interessant ist:

Die Ergebnisse von FurMark, der in den verwendeten Einstellungen nur auf maximale Leistungsaufnahme getrimmt ist, sollte man jedoch nicht überbewerten. Beim Spielen zeigen alle Karten stark schwankende Leistungsaufnahmen, weil die GPUs ständig ihre Stromsparmechanismen nutzen können. Der Rechner nimmt beispielsweise mit Crysis zwischen 162 und 260 Watt auf, im Mittel während einer halben Stunde waren es 220 Watt |

Jedem das seine, aber Furmark ist nur eine Maximaltest und würde ich für realistische Lastmessungen nicht gebrauchen. Niemals wird ein Spiel diese Auslastung erreichen, da diese künstlich herbeigeführt wurde, d.h. dass die Berechnungen nicht unbedingt sinnvoll sind für ein Spiel. Zudem wird ein Spiel auf möglichst wenige Berechnungen bei gleichbleibender Optik optimiert.

(Geändert von smoke81 um 23:24 am Sep. 23, 2009)

-- Veröffentlicht durch spraadhans am 23:13 am 23. Sep. 2009

Deswegen braucht sie auch nur 20w mehr...;)

Ich vertraue da eher CB und THG.

-- Veröffentlicht durch smoke81 am 23:11 am 23. Sep. 2009

Zitat von spraadhans um 21:51 am Sep. 23, 2009 Wäre technisch allerdings schwer nachvollziehbar, wenn die Karte trotz Strukturverkleinerung um 27% bei einer nahezu Verdoppelung der Shadereinheiten weniger Strom unter Volllast verbrauchen würde. |

In der Halbleitertechnik treten Effekte auf, die wir nicht kennen und die sicherlich nicht linear verlaufen.

-- Veröffentlicht durch spraadhans am 22:44 am 23. Sep. 2009

Habs editiert, Hirn schneller als die blöde Tipperei, bin ja schließlich keine Sekretärin...

-- Veröffentlicht durch Xpect am 21:59 am 23. Sep. 2009

Zitat von spraadhans um 21:51 am Sep. 23, 2009 Wäre technisch auch schwer nachvollziehbar, wenn die Karte trotz Strukturverkleinerung um 27% bei einer nahezu Verdoppelung der Shadereinheiten. |

:noidea: Was wolltest du uns sagen?

-- Veröffentlicht durch spraadhans am 21:51 am 23. Sep. 2009

Wäre technisch allerdings schwer nachvollziehbar, wenn die Karte trotz Strukturverkleinerung um 27% bei einer nahezu Verdoppelung der Shadereinheiten weniger Strom unter Volllast verbrauchen würde.

(Geändert von spraadhans um 22:43 am Sep. 23, 2009)

-- Veröffentlicht durch rage82 am 21:43 am 23. Sep. 2009

für mich ist furmark immer noch der test für leistungsaufnahme.

was bringt dir die aktuelle realtität wenn dein nächstes lieblingsgame furmark-gleich deine grafikkarte permanenent über tdp belastet?

ht4u misst mit furmark und bioshock, die haben wenigstens mal geschaut, welches spiel am meisten "last" verursacht.

viele aber messen mit furmark. du könntest auch sagen:

warum seid ihr so blöd und spielt ohne vsync, aktiviert bleibt die karte leise und spart auch strom, wenn du mit realität beim gaming ankommst.

-- Veröffentlicht durch smoke81 am 21:18 am 23. Sep. 2009

Zitat von spraadhans um 18:15 am Sep. 23, 2009 Nö THG misst dieselbe Differenz. |

THG misst unerklärlichen Mist, schreiben sie ja selber:

CodeUnsere früheren Messwerte unter Windows Vista haben uns gezeigt, dass Nvidias GeForce GTX285 und GTX 260 Core 216 um Leerlauf um die 20 Watt weniger Strom verbrauchen als ATIs Radeon HD 4870 1 GB. Bei unserer heutigen Messung, bei der Windows 7 als Betriebssystem zum Einsatz kommt, scheinen die Nvidia-Karten nun etwa 15 Watt mehr zu verbrauchen als die älteren ATI-Boards. |

Zudem misst THG mit Furmark, für die Spiele-Realität recht uninteressant...

Da vertraue ich lieber den Dutzend anderen Seiten, inklusive PCGH, die bei der HD5870 weniger Verbrauch unter Last als eine HD4890 gemessen haben...

-- Veröffentlicht durch AssassinWarlord am 21:04 am 23. Sep. 2009