-- Veröffentlicht durch kammerjaeger am 1:08 am 24. Feb. 2007

Zitat von Lucifer um 22:39 am Feb. 23, 2007 Achja: Die Hersteller bringen so schnell neue Karten weil zum einen der Kunde danach schreit ABER der Hauptgrund ist natürlich der das sie, wenn sie 2 generationen pro jahr entwickeln, zwar nicht das doppelte verdienen, aber dennnoch mehr als nur eine pro jahr. |

Naja, heute sind die Entwicklungszyklen nicht mehr ganz so schnell wie in der Zeit zwischen Riva128 und Geforce3/4. Natürlich kommen mal Dreivate mit mehr oder weniger Takt, deaktivierten Pipes o.ä., aber grundsätzlich neue Architekturen werden nicht mehr so schnell entwickelt wie damals. Trotzdem gibt es mehr versch. Karten als damals, was den Markt für den Kunden unübersichtlicher macht... :blubb:

-- Veröffentlicht durch Redirion am 23:27 am 23. Feb. 2007

lol das sind gerade mal 2 Monate.. darfst stolz auf dich sein:lol:

-- Veröffentlicht durch morethananoob am 22:53 am 23. Feb. 2007

Zitat von jwxs um 21:44 am Feb. 21, 2007 Hallo, nur wenn du unter 18 bist. Welcher unter 18-Jährige kann/will sich die Karten leisten? Und sich noch das vorschreiben lassen, von einem übermotivierten Rollstuhlfahrer. Oder einem Herren wie Beckstein. MfG JWXS |

Halloooo?!? Ich z.B. ??? :lol: Ich spar jetz schon seit Dezember auf den verdammten R600, bzw. ebn 2900XTX² oder (falls die besser abschneiden sollte) 8950 GX2

MfG

Marc

-- Veröffentlicht durch Lucifer am 22:39 am 23. Feb. 2007

hatt eigentlich auch schon jemadn von diesem gerücht gehört, das irgend so ne organisation AMD (ATI) übernehmen will? hatt mir nen kumpel gesagt, das da so nen gerücht im umlauf sei |

Ja so ne investorengruppe. Angeblich. Aber ob da was dran ist... keiner weißes. Macht ja im Endeffekt auch keinen unterschied wer die Aktien hällt.

Achja: Die Hersteller bringen so schnell neue Karten weil zum einen der Kunde danach schreit ABER der Hauptgrund ist natürlich der das sie, wenn sie 2 generationen pro jahr entwickeln, zwar nicht das doppelte verdienen, aber dennnoch mehr als nur eine pro jahr.

-- Veröffentlicht durch THCCryjack am 21:32 am 22. Feb. 2007

Zumindest zu diesem Preis.. Für 99 euro denke ich mal wäre die Karte viel besseer verkauft worden und die Entwickler hätten einen Ansatz gefunden jene welche zu supporten.

Aber ich denke mal im Zeitalter von G80 bzw ubified shader ist die idee eh geschichte. .. wenn man den Spekulationen über die Rechenfähigkeiten der CPU, äh GPU glauben darf... :lol:

-- Veröffentlicht durch BDKMPSS am 21:21 am 22. Feb. 2007

genug Leistung ist eben nicht da, um sehr viele Objekte realistisch mit einander physisch korrekt reagieren zu lassen....

Dazu fehlt schon allein der Durchsatz und noch dazu sind CPUs nicht für massive Parallelberechnungen ausgelegt...

Aber wie gesagt hilft da auch die PhsyX Karte nichts, da sie eben nicht wirklich unterstützt wird und außerdem nicht für in das Spielgeschehen eingreifende Effekte nutzbar ist, da die CPU für jeden einzelnen Frame die Spieler/KI/Wand/Objekt Kollisionen (Sichtfelder usw...) benötigt und wenn es die ständig in den "Beschleuniger" laden und dann wieder für den Nächsten Frame das Ergebnis abrufen müsste (was vor allem mit warten verbunden ist), reicht wieder die Bandbreite nicht, die Latenz ist zu hoch und die Geschwindigkeit ist dahin....

Nur für Grafische Effekte ist die Karte aber lächerlich (und das währe sie auch 2005 gewesen)

-- Veröffentlicht durch Steffen545 am 16:30 am 22. Feb. 2007

ausserdem können das doch heutige Prozessoren einfach mitrechnen oder liege ich da falsch?

Genug leistung ist ja da...

-- Veröffentlicht durch smoke81 am 2:33 am 22. Feb. 2007

Wobei einfach viel zu wenig Zeit verplant wird. Alles muss extrem schnell gehen und 1a funktionieren. Das geht einfach nicht!

Aber so ist auch der Markt heutzutage. Die Leute (Kunden) schreien nach den neuen Karten, in diversen Foren liest man, dass die Leute genug vom warten haben und sich nun einen G80 kaufen werden und und und...

Ich fände es auch vernünftiger entsprechend einzuplanen, dass etwas mal nicht 100%ig so läuft, wie man es berechnet hat und sich Zeit nimmt, um ein ausgereiftes Produkt vorzustellen...

Wenn aber heutzutage etwas nicht gleich klappt, kann man a) ein unfertiges Produkt liefern (siehe Gothic 3) oder b) den Termin verschieben. Ich persönlich warte lieber ein paar Wochen länger, wenn ich davon profitieren kann...

Zur PhsyX:

Allem Anschein nach wird die Karte bald wieder verschwinden. Aber dafür gibt es zig Gründe:

- relativ hoher Einstandspreis (300,-)

- mangelnde Spieleunterstützung (und bei den Spielen, die es unterstützen funktioniert es auch nicht richtig, der Hersteller hat es versäumt, entsprechende Treiber und Optimierungen zu bringen)

- und nicht zuletzt ein wichtiger Faktor: Das Spielerlebnis!

Realistische Phsyik ist ja schon und gut, aber wann profitiert man als Spieler wirklich davon oder bekommt entsprechende Eindrücke? Ob bei einem Shooter die Fensterscheibe realistisch zerspringt oder ob die Teile vorgerendert/vorberechnet wurden, macht kaum einen Unterschied... Bei Sportspielen ist die Physik ausreichend genau... Bei Rennspielen denke ich an ein Schadensmodell, aber es ist extrem aufwändig, Auswirkungen von Fahrzeugschäden realistisch auf das Fahrverhalten zu übertragen.

Das letzte könnte ich mir noch am ehesten vorstellen, aber auch da reicht im Prinzip eine Annäherung aus. Eine realistische Berechnung sorgt kaum für einen "AHA"-Effekt.

Ich sehe einfach keine Kaufmotivation für diese Karte und das ist der Hauptgrund, warum sie ziemlich erfolglos ist...

-- Veröffentlicht durch kammerjaeger am 0:06 am 22. Feb. 2007

Zitat von THCCryjack um 20:38 am Feb. 21, 2007 Ich check da nur was nich... wenn ich so eine Karte entwickle muss ich doch merken oder wissen wohin das ziel führt bzw. was es ist. :noidea: |

Nicht wirklich. Du kannst div. Faktoren bei der Entwicklung nicht voraussehen, weil neue Fertigungsmechanismen, Layouts, Taktraten etc. erst einmal erprobt werden müssen. Klappt dann irgendwas nicht wie gewünscht, verschiebt sich der Launch automatisch. Sonst wäre z.B. die PS3 ja auch wie ursprünglich geplant schon vor Weihnachten gekommen.

Auch mußt Du evtl. geplante Dinge verändern, weil sie eben sonst nicht laufen.

Was im Endeffekt dabei herauskommt und ob es zum Launch auch noch "attraktiv" ist, kommt eben auf das Ergebnis und den Zeitpunkt an. Aber das sieht man erst in der Endphase der Entwicklung. Wäre z.B. die PhysX schon Mitte 2005 rausgekommen, hätte sie sich wohl reissend verkauft. So war sie eine Totgeburt... ;)

-- Veröffentlicht durch jwxs am 21:44 am 21. Feb. 2007

Hallo,

nur wenn du unter 18 bist.

Welcher unter 18-Jährige kann/will sich die Karten leisten?

Und sich noch das vorschreiben lassen, von einem übermotivierten Rollstuhlfahrer. Oder einem Herren wie Beckstein.

MfG

JWXS

-- Veröffentlicht durch jwxs am 21:37 am 21. Feb. 2007

Hallo,

nur wenn du unter 18 bist.

Welcher unter 18-Jährige kann/will sich die Karten leisten?

Und sich noch das vorschreiben lassen, von einem übermotivierten Rollstuhlfahrer. Oder einem Herren wie Beckstein.

MfG

JWXS

-- Veröffentlicht durch DocDoom am 20:49 am 21. Feb. 2007

also weiter abwarten und tee(bier) trinken, warscheinlich werden dann die karten wie damals bei den 9X00 XTs mit nen guten game gebundled oder nen gutschein von Crysis:godlike: und schon sprechen alle nur noch von den neuen ATI Karten. (hatten das phänomen ja schonmal)

aber um mal weiterzuspinnen wenn die die dann mit Crysis oder UT2007 bundeln, werden wir deutschen schon beim Kauf verhaftet ;).

Mfg

Doc

-- Veröffentlicht durch THCCryjack am 20:38 am 21. Feb. 2007

Ich check da nur was nich... wenn ich so eine Karte entwickle muss ich doch merken oder wissen wohin das ziel führt bzw. was es ist. :noidea:

Also wenn der R600 nich der versprochne Knaller wird zum Preis von unter 600 Euro... (die 2900XTX) sehe ich da ganz düstere Aussichten. Derweil schüttet nvidia mit "dumping" preisen alle welt zu. Wenn dann auch noch der midrange Markt gedeckt wird mit der sehr sehr interessanten 8600... Halleluja. :godlike: God save AMD/Ati:ocinside:

Ich erinnere an die in den Startlöchern stehenden 8900 Modelle mit 2.2 Ghz DDR4 und die GX2 8950 :punk:

-- Veröffentlicht durch AssassinWarlord am 20:32 am 21. Feb. 2007

hatt eigentlich auch schon jemadn von diesem gerücht gehört, das irgend so ne organisation AMD (ATI) übernehmen will? :noidea:

hatt mir nen kumpel gesagt, das da so nen gerücht im umlauf sei :shocked:

-- Veröffentlicht durch BlackHawk am 20:04 am 21. Feb. 2007

Schaut mal hier: R600 verschiebt sich bis ins 2. Quartal

Ich denke das der R600 in Sachen Geschwindigkeit nicht ausreichend Vorsprung hat und dabei zu viel Strom verbraucht. Der (finanzielle) Schaden ist für AMD/ATI so schon hoch genug, wenn sie dann wirklich ein solches Produkt bringen würden hätten sie damit keine Chance auf dem Markt. Von daher richtige, aber katastrophale Entscheidung!

mfg BlackHawk

-- Veröffentlicht durch eaking am 11:35 am 21. Feb. 2007

Wahrscheinlich meinte er die Flüssigmetallkühlung, wie sie schon bei Saphire zu sehn war !?!

-- Veröffentlicht durch Henro am 19:26 am 20. Feb. 2007

nein das ist schon was anderes ... und wenn du mal genau hinschaust dann hat auch die oem version heatpipes ;)

-- Veröffentlicht durch AgentOrange996 am 17:00 am 20. Feb. 2007

ich glaub die verdampfer nennen sich heatpipes

-- Veröffentlicht durch Henro am 16:44 am 20. Feb. 2007

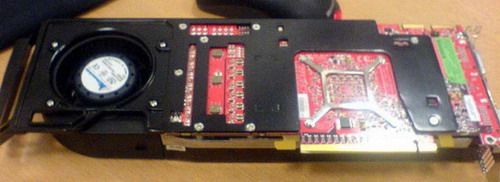

die oem karten sollen billig sein ! deshalb ein design was am optimalsten für eine billige luftkühlerlösung geeignet ist.

die retail karten werden sonen verdampfer-Kühler haben der zwar kleiner ist aber auch teurer.

-- Veröffentlicht durch AssassinWarlord am 7:03 am 20. Feb. 2007

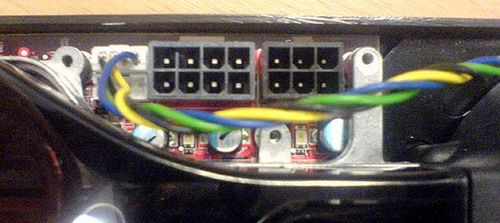

kann mir auch nicht vorstellen das die OEM karte leise sein soll...warum sonst haben die da nen turbnine draufgeschraubt mit 24W...die normalen lüfter haben so um die 3W vieleicht 5W wenns hoch kommt bei der grakakühlung...

finde das auch unlögisch, das die zwei eigentlich gleiche karten bauen, mit unterschiedlichem layout...das sind doch dan doppelte produktionskosten, weil die dan maschinen aufstellen müssen, die ne andere karte bauen, die aber im prinzip genau die selbe ist wie die retail...

-- Veröffentlicht durch BlackHawk am 0:55 am 20. Feb. 2007

Hmmm wird knapp aber könnte mit BTX wirklich passen. Schade nur das es praktisch nirgends einen Nutzen hat, Intel selbst hat BTX doch mehr oder weniger abgekündigt wenn ich mich nicht irre!?

mfg BlackHawk

-- Veröffentlicht durch kammerjaeger am 0:48 am 20. Feb. 2007

Schonmal dran gedacht, daß Dell z.B. BTX verbauen könnte? Dann ist die Lutführung komplett anders und erfordert auch andere Kühler! ;)

-- Veröffentlicht durch BlackHawk am 0:24 am 20. Feb. 2007

Ich glaube da so nicht wirklich dran das ATI die Karte extra für solche Gehäuse gebaut hat, das haben sie bisher doch nicht gemacht oder hast Du schonmal in einem Dell / HP oder was auch immer Rechner so etwas geschweige denn einen dafür tauglichen Tower gesehen? Habe ich bisher auf der Arbeit so noch nicht.

Wozu einen solchen Aufwand betreiben wenn es die Retail Lösungen bisher auch immer gebracht haben (und die neue wohl auch schaffen wird)? Das kann ich halt irgendwie nicht nachvollziehen und lässt mich nur zu der Schlussfolgerung kommen das die Retailkarten in dieser Hinsicht entweder schlechter abschneiden werden, in irgendeiner Hinsicht kastriert werden (haben ja angenlich 30-40 Watt weniger) bzw. lauter sind oder ein deutlich moderneres Kühlsystem besitzen was wieder zu der Frage führt warum die OEM Karte nicht darauf aufsetzt (eine Frage des Preises!?).

Fragen über Fragen... ich will Antworten! :lol:

mfg BlackHawk

(Geändert von BlackHawk um 0:25 am Feb. 20, 2007)

-- Veröffentlicht durch kammerjaeger am 0:17 am 20. Feb. 2007

Weil sie für genau vorgegebene Gehäuse gebaut wurde. In denen mag es das optimale Kühlkonzept sein, nicht aber in Standard-Gehäusen... ;)

-- Veröffentlicht durch BlackHawk am 23:50 am 19. Feb. 2007

Und genau da bin ich mal gespannt was wir da erwarten dürfen... :)

Für ausgeklügelte Kühllösungen war ATI bisher nicht bekannt, sieht man ja auch an der OEM Variante. Die macht mir eher so den Eindruck als das sie so extrem gebaut wurde damit sie in den Heimrechnern möglichst leise zu Werke geht. Das würde für mich bedeuten die Retail Variante ist entweder lauter oder technisch durchdachter, was die Frage aufwerfen würde warum dann die OEM überhaupt so ausschaut :noidea:

mfg BlackHawk

(Geändert von BlackHawk um 23:51 am Feb. 19, 2007)

-- Veröffentlicht durch kammerjaeger am 23:38 am 19. Feb. 2007

Naja, solange wie schon gesagt die Retail-Version nicht so extrem ist, sollte sie in die meisten Gehäuse passen...

-- Veröffentlicht durch AssassinWarlord am 22:28 am 19. Feb. 2007

naja vieleicht gibts barebones, die vorne so nen wulst drannen haben, also wenn man von oben auf die front schaut so L förmig ^^

damit die graka da platz hat ^^

oder ATI sägt das teil mittig durch und baut dann auf Dual Basis ^^ gibtja genug alte grakas, die danach aufgebaut haben...also das die halbe grafikkarte noch über der eigentlichen graka schwebt ^^

-- Veröffentlicht durch DocDoom am 21:52 am 19. Feb. 2007

was solls, eigenes case bauen und wakü druff.

aber mal im ernst, meint ihr nich auch das der schuss nach hinten los geht. warum nich gleich nen halben meter. war ja schon immer ein wenig pro ati. aber so langsam zweifle ich selber an denen.(gerade weil ich meine 6800le immer mehr lieb gewinne, nicht zuletzt wegen der treiber) <-- hab ich das geschrieben ????:noidea:????.

wo soll das noch hingehen, wir kaufen uns das passende case zur graka ??

den begriff barebone will ich mal garnich innen raum werfen ;)

Mfg

Doc

-- Veröffentlicht durch isnoguter am 21:03 am 19. Feb. 2007

stimmt ich hab mal gemessen in mein case kann ich eine graka mit einer länge von max 28,5cm rein bauen sonst muss ich bisschen anfangen zu sägen und pfeilen

-- Veröffentlicht durch kammerjaeger am 19:10 am 19. Feb. 2007

Zitat von THCCryjack um 15:09 am Feb. 19, 2007 32 ist die 7900 GX2 auch... ist schon ein Monster. Sollte aber in fast jeden Midi Tower passen. Haben doch alle mindestens eine Tiefe von 400 mm. |

Dabei darf man aber die Festplattenschlitten nicht vergessen, die bei vielen Gehäusen nicht modular rausnehmbar sind... ;)

-- Veröffentlicht durch AssassinWarlord am 17:55 am 19. Feb. 2007

ich frage mich, warum es überhaupt ne OEM und ne retail gibt...beide haben die selbe leistungsdaten...aber unterschiedliche länge @ layout :noidea: :buck:

-- Veröffentlicht durch THCCryjack am 15:09 am 19. Feb. 2007

Zitat von Mitfreak um 11:00 am Feb. 19, 2007 Laut einiger Foren sollen die GraKas mit der R600 GPU um die 32 cm lang sein Wo soll man die sich bitte hinstecken...?  |

32 ist die 7900 GX2 auch... ist schon ein Monster. Sollte aber in fast jeden Midi Tower passen. Haben doch alle mindestens eine Tiefe von 400 mm.

Ich habe in meinem Silverstone sogar nach vorn nen Lüfter mit dahinterliegenden Halteschienen... Die Karten müssten/dürften 34 cm :punk:lang sein

-- Veröffentlicht durch Maddini am 11:23 am 19. Feb. 2007

Die OEM-Variante, bei der der Kühler praktisch über die komplette Karte verbaut ist, soll stolze 12,4 Zoll, umgerechnet 31,5 cm, lang sein. Die Endkundenvariante ist dabei ein wenig aufrüstfreundlicher und „nur“ 9,5 Zoll, 24,1 cm, lang. |

die oem karten haben diese länge: die haben auch teilweise eigene cases wo eine halterung auf der anderen seite ist für die karte.

die normalen karten haben eine länge von 24,1cm. somit kürzer als eine 8800GTX :thumb:

-- Veröffentlicht durch Mitfreak am 11:00 am 19. Feb. 2007

Laut einiger Foren sollen die GraKas mit der R600 GPU um die 32 cm lang sein Wo soll man die sich bitte hinstecken...?

-- Veröffentlicht durch THCCryjack am 20:48 am 18. Feb. 2007

Im April.. :lol: netter Versuch. Laut anderen Quellen wird genau dann die 8900 GTX (700/2200 MhzDDR4) GTS (DDR4) bzw 8950 GX2 (550/2000 Mhz DDR4) gelauncht... Außerdem startet dann auch der wahrscheinlich TopNachfolger der 7600GT... die 8600

8600 Ultra: 64 SP, core 500 MHz, memory 1400 MHz, 512 MB, 256-bit, $179

8600 GT: 48 SP, core 350 MHz, memory 1200 MHz, 256 MB, 128-bit, $149

8300 GT: 32 SP, core 500 MHz, memory 1200 MHz, 256 MB, 128-bit, $99

8300 GS: 24 SP, core 500 MHz, memory 1000 MHz, 256 MB, 128-bit, $79

und zum 3DMark 05... mit ner GX2 schaffe ich 14833 Punkte... :thumb:

-- Veröffentlicht durch AssassinWarlord am 20:09 am 18. Feb. 2007

habe ich was überlesen bei google? :red: hmm also ist der 06er bench doch nicht mit nem FX55 gemacht worden..sauerrei... ^^

-- Veröffentlicht durch Irrwisch am 20:05 am 18. Feb. 2007

gibt es dann gleich nen passenden tower mit dazu? *g*

-- Veröffentlicht durch BlackHawk am 20:04 am 18. Feb. 2007

Ok, meiner Recherche und diesem Artikel nach schaut die Karte so aus, ebenso wie die Ergebnisse wie folgt lauten:

- 3DMark03 (AMD Athlon64 FX55, First WHQL driver, 1024×768 noAA noAF)

- X2800XTX: 43606

- 8800GTX: 41264

- X2800XT: 34623

- 8800GTS: 32567

- 7950GX2: 29257

- 3DMark05 (AMD Athlon64 FX55, First WHQL driver, 1024×768 noAA noAF)

- X2800XTX: 17387

- X2800XT: 16135

- 8800GTX: 15467

- 8800GTS: 13773

- 7950GX2: 12886

- 3DMark06 (Intel Core 2 Extreme QX6700 @ 5300MHz, 353.3×15)

- 3DMark Score: 15032 3DMarks

- SM 2.0 Score: 5754 Marks

- SM 3.0 Score: 5841 Marks

- CPU Score: 7615 Marks

Das der 3DMark06 Wert so gut ist liegt ausschliesslich an dem mit 5.3GHz getakteten Quad Core, dennoch scheint die Karte zumindest auf den ersten Blick leicht schneller zu sein als die nVidia Pendants, sonderlich viel schneller für das was sie dann später kommen würden ist es aber nicht. Da kann nVidia mit dem Refresh evtl. ja wirklich relativ leicht wieder zur Krone greifen - theoretisch. Mal abwarten wie sich die Karten mit ausgereifteren Treibern so schlagen :)

mfg BlackHawk

(Geändert von BlackHawk um 20:06 am Feb. 18, 2007)

-- Veröffentlicht durch AssassinWarlord am 20:00 am 18. Feb. 2007

Naja...solche flagböötchen gabs aber schon viel früher...von 3DLabs :D

-- Veröffentlicht durch Rulinator am 19:47 am 18. Feb. 2007

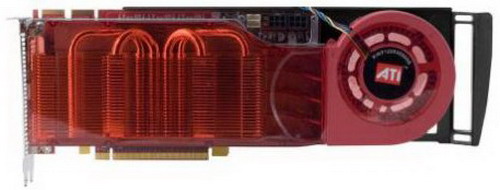

öhm, hab den thread mal überfolgen und die pics gesehen da...

ähm mal im ernst... DAS ist eine grafikkarte?! :noidea:

-- Veröffentlicht durch AssassinWarlord am 19:06 am 18. Feb. 2007

google :lol:

-- Veröffentlicht durch BlackHawk am 18:53 am 18. Feb. 2007

wo hast du die benches überhaupt her?

mfg BlackHawk

-- Veröffentlicht durch AssassinWarlord am 18:46 am 18. Feb. 2007

also in 3dmark 03 hatt ne 8800GTX so 41274 punkte, und in 05er bench 15467 Punkte...auch mit nem FX55 :noidea:

also elbst die X2800XT ist ab 3dmark 05 der 8800GTX überlegen :)

die X2800XTX ist übrigens mit 700Mhz Core und 1,1Ghz RAM (also dan 2,2Ghz wegen DDR) getaktet :shocked:

aber über die anzal der pipes kann ich nüx finden...

(Geändert von AssassinWarlord um 18:47 am Feb. 18, 2007)

-- Veröffentlicht durch kammerjaeger am 18:42 am 18. Feb. 2007

Zitat von AssassinWarlord um 18:27 am Feb. 18, 2007 Benchmarks gibts ja schon welche im Netz: X2800 XTX 3D Mark 06: 15032 (mit nem FX55 gebencht) |

Das wäre dann ca. 50% über einer 8800GTX! :godlike:

-- Veröffentlicht durch AssassinWarlord am 18:27 am 18. Feb. 2007

Benchmarks gibts ja schon welche im Netz:

X2800 XTX

3D Mark03: 43606

3D Mark 05: 17387

3D Mark 06: 15032

X2800 XT

3D Mark03: 34623

3D Mark 05: 16135

(mit nem FX55 gebencht)

vorerst wird es eine X2800XTX (1GB DDR4) geben (die OEM Version)

dann noch eine X2800XTX (1GB DDR4) für den Retail Markt

dann gibts noch eine X2800XT (512MB DDR3)

und eine X2800XL (512MB DDR3)

alle haben eine 512bit Speicheranbindung :shocked:

die X2800XTX ist für März geplant, die anderen beiden (XT und XL) sollen ert im Aprill kommen...

hier noch ein paar bilder:

also die graka wird sicherlich so 220W verbrätzeln...wenn die da schon einen 24W (!!!) lüfter draufgeschraubt haben, damit die es schaffen, die extreme abwärme abzuführen...oha..da will ich garnicht erst wissen, wie laut die bei belastung wird :buck: :bomb:

(Geändert von AssassinWarlord um 18:42 am Feb. 18, 2007)

-- Veröffentlicht durch BlackHawk am 17:19 am 18. Feb. 2007

Dann stimmte das also echt das auf der Cebit nur Demos hinter verschlossenen Türen gezeigt werden sollen :(

Naja, kann man nix machen. Dennoch hat nVidia dann aber nen gewaltigen Vorsprung :(

mfg BlackHawk

-- Veröffentlicht durch kammerjaeger am 17:14 am 18. Feb. 2007

Serienreife soll afaik Juni/Juli sein.

-- Veröffentlicht durch BlackHawk am 16:28 am 18. Feb. 2007

Sommer? Wie kommst Du jetzt auf Sommer?

mfg BlackHawk

-- Veröffentlicht durch kammerjaeger am 16:14 am 18. Feb. 2007

Zitat von BlackHawk um 15:28 am Feb. 18, 2007 Ich stimme Kammerjaeger zwar zu, bin aber dennoch der Meinung das man solche Karten erst gar nicht kaufen, eigentlich sogar boykottieren sollte. Zwar steigt mit der Leistung meistens auch der Verbrauch, aber wo soll das bitte enden? Darin das wir bald alle externe PCIe Grafikkarten haben die in einem Gehäuse mit eigener Wasserkühlung arbeiten und den Tower in Grösse und Preis übertrumpfen!? Ich finde die aktuellen 8800'er noch einigermassen erträglich, die 8800GTS sogar ganz gelungen da sie weniger verbraucht als meine aktuelle 1950XT, dennoch aber der falsche Weg ;) mfg BlackHawk |

Ohne Frage ist es der falsche Weg. Aber auch das wird sich bald ändern. Genauso wie Intel mit dem C2D endlich weg ist von ihren Heizkraftwerken, so werden auch die Grafikchips irgendwann wieder sparsamer. Ist nur eine Frage der Zeit...

Der Unterschied zur CPU-Entwicklung ist jedoch der, daß die Prescotts auch Idle viel Saft verbraten haben. Auch die kleinen Modelle waren kaum sparsamer.

Bei den GraKas hingegen hat man die Wahl: Entweder MidRange mit erträglichem Verbrauch auch unter Last oder eben HighEnd, wobei dann die paar Euro für Strom nicht interessieren...

Back to Topic:

Es wurde ja schon angedeutet, daß die 240-270W zum einen nur auf das Top-Modell zutreffen und dort wohl auch nur beim Vorserien-Modell, während die endgültige wahrscheinlich klar darunter liegt. Nicht ohne Grund ist der Launch erst für den Sommer geplant und nicht schon nächste Woche...

Laßt uns doch einfach abwarten, was die Verkaufsversion dann zu bieten hat und die kleineren Modelle leisten und verbrauchen, vorher würde ich mir da keine Gedanken machen. Ist doch alles reine Spekulation...

-- Veröffentlicht durch BlackHawk am 15:57 am 18. Feb. 2007

Nicht wirklich, die sind nochmal ne kleine Welt für sich... ;)

Aber wir sollten echt mal wieder zum R600 zurück kommen :lol:

mfg BlackHawk

-- Veröffentlicht durch DocDoom am 15:55 am 18. Feb. 2007

schweifen wir gerade in richtung Rechenzentren ab ???

aber hast ja recht, der november ist auch schon zu meinem Hass-Monat geworden, weil da immer die stromrechnung bzw nachzahlung ansteht.

(Geändert von DocDoom um 15:56 am Feb. 18, 2007)

-- Veröffentlicht durch BlackHawk am 15:52 am 18. Feb. 2007

Ganz genau. Meiner Meinung nach müssten auch mal die Computer Zeitschriften da genauer drauf eingehen da es ja wirklich viele Leser gibt die Ihrem Urteil vertrauen. Das wird meistens alles zu Oberflächlich mit "hoher Verbrauch" oder "wird sehr warm" abgeklatscht. Die die sich damit auskennen kaufen sich nur noch selten solche Zeitschriften, ich lese Sie auch nur noch wenn ich auf der Firma mal eine in die Hand bekomme.

Aber man will es sich ja im schlimmsten Fall nicht mit den Herstellern verscherzen... :lol:

Dabei hat es bei Intel ja immerhin geklappt, auch wenns ewig gedauert hat!

@DocDoom:

Das war bei mir damals mit dem Athlon XP un der Wakü genauso, aber das kann nicht Sinn und Zweck sein. Du bist ja auch nicht der einzige, multiplizier das (Nutzer)Verhältnis mal auf die Weltbevölkerung.

mfg BlackHawk

(Geändert von BlackHawk um 15:54 am Feb. 18, 2007)

-- Veröffentlicht durch DocDoom am 15:51 am 18. Feb. 2007

weiß garnich was ihr habt, im winter (da wo normalerweise gezockt wird, wegen schlecht wetter) ist das doch garnich so schlimm, könnt die heizung doch dann wenigstens 2 stufen runterregeln, spart auch :lol::lol::lol:

PS: ich hatte die Heizung in meinen Arbeitszimmer das letzte mal vor ca 1nem Jahr an ;)

Mfg

Doc

-- Veröffentlicht durch PUNK2018 am 15:44 am 18. Feb. 2007

Genau das will ich damit sagn! das ist ähnlich wie bei Intel... da war die verlustleistung lange auch ein thema mit sieben siegeln...

guggt man sich dort heute um wird man feststellen das die verlustleistung in einem niedrigeren niveau zur leistung steht...

ich finds einfach nich pralle das ich für aktuelle spiele erstmal fett geld für ne grafikkarte hinlegen müsste und dann auchnoch n kleines heizkraftwerk da hab...

wie blackhawk schon sagte... das is der falsche weg....

voralledem will ich nicht wissen wie die kühlösungen nachher aussehn... so ein pcb ist nicht unendlich... irgendwann wird das zu schwer oder zu laut... und da werden viele hersteller auf laut setzen.... auch wenn man seit einigen monaten bzw seit schon ein paar jährchen mitbekommt das auch bei den herstellern langsam hirn mitarbeitet und viele hersteller von haus aus Silent oder Passivkühler montieren... die 2XX watt müssen aber auch irgendwie weg...

-- Veröffentlicht durch BlackHawk am 15:28 am 18. Feb. 2007

Ich stimme Kammerjaeger zwar zu, bin aber dennoch der Meinung das man solche Karten erst gar nicht kaufen, eigentlich sogar boykottieren sollte. Zwar steigt mit der Leistung meistens auch der Verbrauch, aber wo soll das bitte enden? Darin das wir bald alle externe PCIe Grafikkarten haben die in einem Gehäuse mit eigener Wasserkühlung arbeiten und den Tower in Grösse und Preis übertrumpfen!?

Ich finde die aktuellen 8800'er noch einigermassen erträglich, die 8800GTS sogar ganz gelungen da sie weniger verbraucht als meine aktuelle 1950XT, dennoch aber der falsche Weg ;)

mfg BlackHawk

-- Veröffentlicht durch Maddini am 15:20 am 18. Feb. 2007

ich stimm kammerjäger voll und ganz zu :thumb::ocinside:

-- Veröffentlicht durch kammerjaeger am 13:50 am 18. Feb. 2007

Zitat von PUNK2018 um 13:38 am Feb. 18, 2007 Auch wenns täglich nur eine Stunde Last ist ist das schon übelst viel... Naja is halt wie immer ein 2 schneidiges schwert.... Mehr leistung im grafischen bringt auch mehr leistungshunger mit sich,.... |

Ok, dann rechnen wir mal:

Selbst bei 150W Mehrverbrauch ggü. einer Midrange-Karte wären das bei einer Stunde pro Tag ca. 10-11,- im Jahr. Wer 600,- für das Top-Modell ausgibt, den dürfte das wenig interessieren! Und wer HighEnd kauft, wird auch das passende NT haben und dort nicht am falschen Ende sparen, was dann durch einen guten Wirkungsgrad wieder etwas rausholt...

-- Veröffentlicht durch Maddini am 13:43 am 18. Feb. 2007

eben. wenns einem zuviel strom ist ne midrange graka kaufen und details etwas zurück schraben :thumb:

-- Veröffentlicht durch PUNK2018 am 13:38 am 18. Feb. 2007

Auch wenns täglich nur eine Stunde Last ist ist das schon übelst viel...

Naja is halt wie immer ein 2 schneidiges schwert.... Mehr leistung im grafischen bringt auch mehr leistungshunger mit sich,....

-- Veröffentlicht durch kammerjaeger am 13:36 am 18. Feb. 2007

Die Karte läuft auch nur selten unter Last, von 8 Stunden oder mehr am Tag kann da keine Rede sein. Und Idle nehmen sich die Karten im Verbrauch alle nicht viel, der Unterschied fällt erst unter Last auf...

-- Veröffentlicht durch PUNK2018 am 13:08 am 18. Feb. 2007

Der Wäschetrockner läuft aber nich 8 oder mehr stunden am tag ^^.... mess mal nach... dann wirste sehn das im prinzip der verbrauch vonnem trockner oder ner waschmaschine in relation zu nem pc der gut was brät lachhaft ist....

ich verbrate mit meinem strom spar pc immernoch mehr als die waschmaschine im jahr ^^

-- Veröffentlicht durch Dargor am 13:02 am 18. Feb. 2007

nun, von der 8800GTX hieß es auch erst, sie würde über 200 Watt verbraten.

Im Endeffekt sinds dann doch "nur" 150 :thumb:

Und mal ganz ehrlich, wer Geld für solche Grakas hat, der kann

auch den Strom bezahlen. Und mal zum Vergleich ... Muttis Wäschetrocker

oder der Küchenherd haben je über 2000Watt, was ist da schon ein PC ;)

-- Veröffentlicht durch BlackHawk am 13:41 am 17. Feb. 2007

So kann man das auch ausdrücken :lol:

Das Schlimme (bzw. Gute) ist ja das an den meisten Gerüchten irgendwo nen Stück dran ist, selten wird einfach nur so was in die Welt gesetzt. Zumal ja auch nicht wirklich was bis zum Release geheim bleiben kann bei dem Durchlauf den so eine Karte bei den Herstellern und folglich evtl. Websites hat :)

mfg BlackHawk

-- Veröffentlicht durch jwxs am 13:19 am 17. Feb. 2007

Hallo Blackhawk,

was nach deiner Ausage dann noch offen wäre ist im Grunde das Gesamtpaket.

MfG

JWXS

-- Veröffentlicht durch BlackHawk am 12:47 am 17. Feb. 2007

Ich bezweifle stark das es sich um einen Fake handelt, wiederhole aber nochmals das es sich bei der gezeigten Karte nur um die OEM Variante handelt. Wie die Retail Karte ausschaut wissen bisher wohl nur Eingeweihte bzw. die Hersteller.

Bezüglich der Bezeichnung stimmt das Kürzel XTX auch. In dem Artikel wurde erwähnt das es wohl zwei XTX Versionen geben wird was kürzlich bestätigt wurde: klick mich

Das was mehr oder weniger noch offen ist, ist die Geschwindigkeit, der endgültige Verbrauch sowie das Layout der Retail Karten :)

mfg BlackHawk

-- Veröffentlicht durch faulpelz am 11:43 am 17. Feb. 2007

ist mit sicherheit ein fake zumal der name r600xtx garnicht passt ati hat noch nie die kern bezeichnuntg als kartennamen genommen

-- Veröffentlicht durch jwxs am 9:40 am 17. Feb. 2007

Hallo,

Strompreise werden sicher nicht sinken. Und wenn der Verbraucher nicht reagiert.... Sorry, wenn ein wenig Off-Topic, aber egal wie gut die Karte ist, der Verbrauch ist selbst für Promotion indiskutabel.

MfG

JWXS

-- Veröffentlicht durch Silencer11 am 9:06 am 17. Feb. 2007

LOL Was will ATI mit so einen hohen Stromverbrauch! Das ist SINNNNLOSSS!!! Vor allem wenn die Strompreise noch höher gehen will ich mir kein Stromkraftwerk in mein Zimmer stellen!

Meiner Meinung nach sollte der Sin eines neuen Grakachips sein weniger zu verbrauchen aber auch gute performance bringen!

Naja die Denke alle Wir haben ein "Geldsch****er"

:lol:

-- Veröffentlicht durch BlackHawk am 21:07 am 16. Feb. 2007

Zitat von kammerjaeger um 13:10 am Feb. 16, 2007 Glaub ich nicht. Damit wird ATI sich nicht auf den Markt trauen... In meinen Augen ein Fake, solange ATI nicht total verzweifelt ist. ;) |

Werden sie aber (leider). Für den OEM Markt wird es die o.g. Version mit hintem angebauten Lüfter geben, das ist mehr oder weniger amtlich und zieht sich auch die letzten Monate geradlinig durch die Gerüchteküche (siehe erste Skizzen). Viel mehr interessiert mich wie das Modell für den Normalkäufer ausschaut, schliesslich wird sich dort am Verbrauch nicht viel ändern, gekühlt werden muss ja aber dennoch :noidea:

Ausserdem soll auf der Cebit keine R600 Karte vorgestellt werden, "angeblich" nur hinter verschlossener Tür ein paar Techdemo Durchläufe - aber warten wir es mal ab. Wir werden es schon erleben :biglol:

Spekulation ist doch was feines, bietet viel Raum für Fantasie... ;)

mfg BlackHawk

(Geändert von BlackHawk um 21:09 am Feb. 16, 2007)

-- Veröffentlicht durch jwxs am 14:17 am 16. Feb. 2007

Hallo,

240-270 Watt Leistungsaufnahme sind ja wohl hoffentlich ein übler Scherz.

Da sinkt bei Prozessoren der Stromverbrauch langsam aber sicher bei trotzdem gleicher oder höherer Leistung, und dann so etwas. Bin eh nicht als ATI-Fan bekannt, aber sowas turnt echt ab.

MfG

JWXS

-- Veröffentlicht durch Maddini am 13:33 am 16. Feb. 2007

für den OEM Markt werden die karten so aussehn, für normalkunden wird ein anderer kühler genommen der nicht übers PCB drüberschaut, bekommt aber 2 lüfteranschlüsse, 1 6pin und einen 8pin anschluss :thumb:

Effizienzgurus

soferns wahr ist

-- Veröffentlicht durch t4ker am 13:13 am 16. Feb. 2007

:punk: *göttlich* Aber Wunderwaffen ham die auch ne!

-- Veröffentlicht durch kammerjaeger am 13:10 am 16. Feb. 2007

Glaub ich nicht. Damit wird ATI sich nicht auf den Markt trauen...

In meinen Augen ein Fake, solange ATI nicht total verzweifelt ist. ;)

-- Veröffentlicht durch ueker123 am 12:51 am 16. Feb. 2007

Moin,

ich bin grad beim stöbern auf erste Details der neuen Ati R600 Serie gestoßen.

Die GPU wird auf 80 nm Technologie basieren und es wird zu beginn 2 Versionen der R600 XTX geben.

1 für Endkunden und 1 Retail.

Die Version für Endkunden wird ca. 31 cm lang sein und 270 verbraten.

Aber sehr selbst:

Klick